Intelligenter, „agentisch“ und personalisiert – das sind die neuen Attribute für KI, die Googles CEO Sundar Pichai zum Auftakt der Entwicklerkonferenz Google I/O verlauten lässt. Dahinter steckt ein allgemeiner Trend: Die KI soll noch besser, korrekter und ausführlicher Fragen beantworten können, aber auch Aufgaben gleich selbst erledigen und immer im Sinne des Anwenders handeln. Und irgendwann, so erträumt es Demis Hassabis, CEO von Google Deepmind, haben wir dann ein Weltenmodell, das alles kann – wie ein echtes Gehirn.

Googles leistungsfähigste Modelle Gemini 2.5 Flash und Pro legen laut Hassabis schon das Fundament für diese neue KI-Welt. Google will sie weiter verbessert haben und mehr Menschen zugänglich machen. Gemini 2.5 Flash zieht in die Gemini App und ist für Entwickler via Google AI Studio sowie Vertex AI verfügbar – 2.5 Pro soll bald folgen. Google hatte bereits eine Vorab-Version für Entwickler verfügbar gemacht. Laut Google ist Gemini 2.5 Pro in der WebDev Arena mit einem ELO von 1420 führend sowie in allen LMArena Kategorien – in einer solchen Arena treten KI-Modelle gegeneinander an und werden bewertet.

Gemini kann denken, sprechen und den Browser steuern

Neu ist zudem Deep Think, ein sogenanntes Reasoning Model, das in Gemini 2.5 steckt. Reasoning bedeutet, das Modell soll nicht nur Inhalte wiedergeben können, sondern auch logisch verknüpfen. Beide Modelle können zudem bald nativ Audio generieren. Dabei lässt sich die Tonart, ein Akzent und der Stil eines Sprechers bestimmen. Flüstern, dramatisch sprechen, alles möglich.

Auch taugen Gemini 2.5 Flash und Pro als Agenten, die den Browser steuern können. Daran arbeitet Google schon länger unter dem Namen Project Mariner. Das zieht nun in die Gemini API und Vertex AI ein. Google unterstützt zudem das Model Context Protokol (MCP), das Anthropic entwickelt hat. Dank des MCP kann Gemini Informationen zusammensammeln und Listen erstellen, wie etwa wo eine Wäscherei ist. Das Protokoll macht Webseiten für Agenten „lesbar“.

250 US-Dollar für einen VIP-Pass

Project Mariner gibt es für Kunden des neuen KI-Ultra-Abos von Google bereits in den USA zu testen. Google nennt das einen „VIP-Pass“ – und lässt den auch bezahlen: er kostet 250 US-Dollar im Monat. Inklusive sind die höchsten Nutzungslimits für alle KI-Dienste, sie bekommen etwa zudem als erstes Zugang zu Deep Think, Flow und etwa Whisk, mit dem man Bilder in kurze Animationen verwandeln kann. Zum Abo gehören auch 30 TB Speicherkapazitäten für Fotos und andere Dokumente. AI Premium wird in AI Pro umbenannt – man kann dieses behalten und bekommt auch hier mehr Zugriffe, etwa auf Flow.

Die Suche wird in den USA um den AI Mode erweitert. Der war bisher bereits in einer Testumgebung der Google Labs verfügbar. Hinter dem AI Mode stecken ebenfalls die Reasoning-Fähigkeiten. Damit sollen komplexere Fragen in der Suche beantwortet werden können. Dazu nutzt Google das Web aber auch den eigenen Knowledge Graph, also jenes Wissen, das Google in einer gigantischen Datenbank gesammelt hat. In dieser Datenbank stecken auch die Shoppingergebnisse. So kommt es, dass Google Shopping über den AI Mode KI-Funktionen bekommt. Dazu gehört die Möglichkeit, Kleidung virtuell anzuprobieren, so etwas hatte Google bereits früher getestet, außerdem gibt es einen agentischen Checkout.

Imagen 4 und Veo 3 sind Googles neue und verbesserte Video- und Bildgeneratoren. Veo 3 kann künftig nativ Audio generieren, Text und Umgebungsgeräusche etwa. Mit Flow sollen sich längere Filme erstellen lassen, etwa indem man eine bessere Kontrolle über Charaktere und Stile bekommt. Google scheint das mit einem Video gleich zum Start der I/O beweisen zu wollen. Ein Zoo wirbelt da eine klassische Wild-West-Stadt auf. Papageien fliegen umher, ein T-Rex aus Klemmbausteinen brüllt, es staubt. Doch die ballonartigen Buchstaben, die zur I/O begrüßen, glänzen sauber im blauen Himmel.

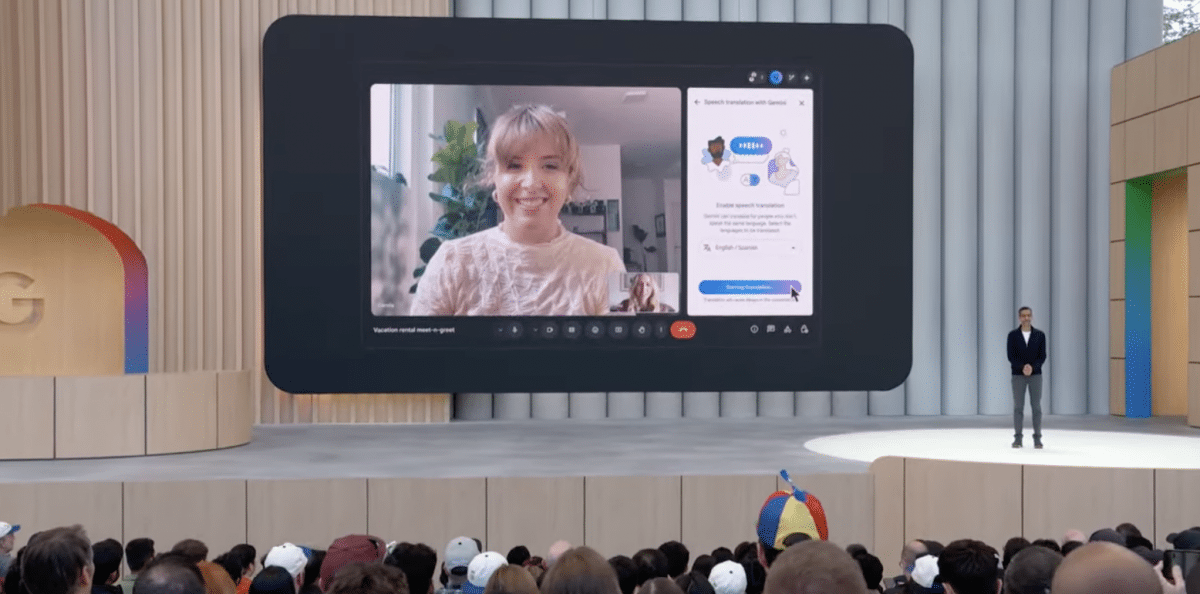

Canvas, Googles KI-Skribbletool, Deep Research, der Chatbot für wissenschaftliche Aufgaben, bekommen Updates, genauso wie Gmail und Google Meet – dazu gehören E-Mails, die Gemini so beantwortet, wie man selbst schreibt sowie synchrone Übersetzungen in Meet. Zunächst gibt es die aber nur für wenige Sprachen.

Neu ist Google Beam: Eine 3D-Kommunikationsplattform, die auf KI basiert. Auch hier können Gespräche zwischen zwei Personen simultan übersetzt werden. Und das nicht etwa in einer Computerstimme, sondern in der des jeweiligen Sprechers. Android XR soll Gemini auf smarte Brillen und Headsets bringen. Gemini Live ist zudem auf Android und iOS-Geräten verfügbar. Das ist jene Funktion, bei der man in Echtzeit mit der KI über das sprechen kann, was man sieht – auf dem Bildschirm oder mittels Kamera. Dank agentischer Fähigkeiten ist es bald auch möglich, dass Gemini zwischendurch mal eben einen Shop anruft und nach einem Ersatzteil fragt, während man dank Hilfe der KI eine Fahrradreparatur durchführen will. So zeigt es Google in einem Video.

(emw)

Dieser Link ist leider nicht mehr gültig.

Links zu verschenkten Artikeln werden ungültig,

wenn diese älter als 7 Tage sind oder zu oft aufgerufen wurden.

Sie benötigen ein heise+ Paket, um diesen Artikel zu lesen. Jetzt eine Woche unverbindlich testen – ohne Verpflichtung!