Höflichkeit gegenüber ChatGPT hat im wahrsten Sinne des Wortes einen hohen Preis. Denn jedes „Bitte“ und „Danke“ der Nutzer kostet OpenAI Geld. Über zwei Drittel der Nutzer sind freundlich zum KI-Chatbot – einige sogar aus etwas überraschenden Gründen

Digitale Höflichkeit hat ihren Preis

Gute Manieren sind wichtig. Doch bei ChatGPT haben sie einen überraschend hohen Preis. Jedes „Bitte“ und „Danke“, das Nutzer in ihre Anfragen an den KI-Chatbot einfügen, kostet OpenAI bares Geld. Laut CEO Sam Altman belaufen sich diese Kosten mittlerweile auf „zig Millionen Dollar“.

Der Grund dafür ist einfach. Denn jedes zusätzliche Wort in einem Prompt bedeutet mehr Daten, die verarbeitet werden müssen. Das erfordert zusätzliche Rechenleistung und damit mehr Energie in den Rechenzentren. Bei Millionen von Anfragen täglich summieren sich diese scheinbar kleinen Höflichkeitsfloskeln zu erheblichen Beträgen – und dass, obwohl ChatGPT ein deutlich geringerer Stromfresser ist, als gedacht.

Die KI nicht verärgern

Höflichkeit gegenüber KI-Systemen ist nichts Außergewöhnliches, sondern üblich. Eine Umfrage ergab, dass 67 Prozent der US-Nutzer nett zu ihren Chatbots sind. Die große Mehrheit von 55 Prozent tut das aus Anstand, während zwölf Prozent sogar angeben, dass sie die künstliche Intelligenz für den Fall eines möglichen KI-Aufstands in der Zukunft wohlgesonnen stimmen wollen.

In einem Post auf X antwortete Sam Altman auf die Frage, wie viel Geld OpenAI durch die Höflichkeit der Nutzer an Stromkosten verloren habe, mit den Worten: „Zig Millionen Dollar, gut angelegt – man weiß ja nie.“ Diese Aussage mit einem Augenzwinkern hat in sozialen Medien für Diskussionen gesorgt, ob es sich um geschickte PR handelt oder ob dahinter tatsächlich langfristige Überlegungen zur Mensch-KI-Interaktion stehen.

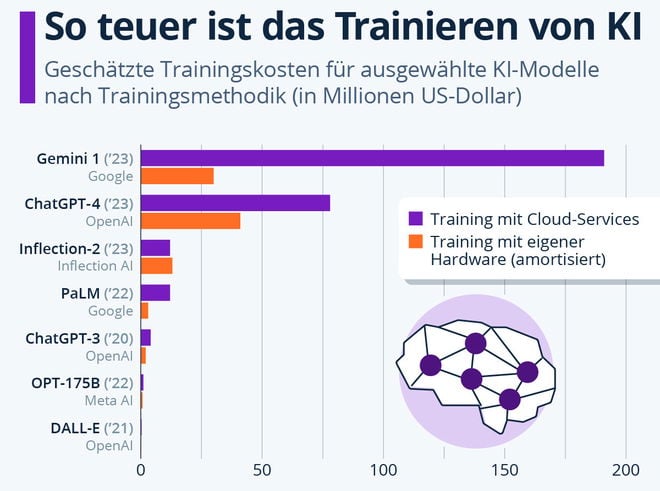

Infografik Generative KI: Schon das Trainieren von KI-Modellen ist teuer

Umweltauswirkungen digitaler Kommunikation

Die Debatte um höfliche Formulierungen gegenüber ChatGPT unterstreicht die oft übersehenen ökologischen Kosten der KI-Nutzung. Die Entwicklung und der Betrieb von Large Language Models ist enorm energieintensiv. Laut einer Untersuchung der Washington Post in Zusammenarbeit mit Forschern der University of California kann allein das Generieren einer 100-Wörter-E-Mail über eine KI etwa 0,14 Kilowattstunden Strom benötigen.

Auch der Wasserverbrauch ist beträchtlich. So deuten neuere Berichte darauf hin, dass OpenAIs GPT-4 bis zu drei Wasserflaschen benötigt, um lediglich 100 Wörter zu generieren. Das Wasser wird zur Kühlung der Rechenzentren benötigt, um eine Überhitzung der Server zu verhindern. Einige Experten, wie Kurtis Beavers von Microsoft, argumentieren dennoch, dass höfliche Umgangsformen zu besseren und respektvolleren Ergebnissen führen können, da die KI oft den Ton und die Detailtiefe des Prompts widerspiegelt.

Effizientere Technologie

Unter Umweltaspekten wäre es damit am besten, ganz auf KI zu verzichten. Das mag für einzelne Personen eine Option sein, ist im großen Maßstab allerdings nicht realistisch. Deswegen beschäftigen sich etliche Ingenieure mit Möglichkeiten, die Nutzung von KI energieeffizienter und kostengünstiger zu gestalten. So werden etwa neue Speichertechnologien wie PoX entwickelt. Auch neuartige Chips auf Bismut-Basis sind schneller und verbrauchen weniger Energie als gewöhnliche Siliziumchips.

Bis diese Technologien in großen Quantitäten hergestellt werden können, dauert es jedoch noch einige Zeit. Bis dahin wollen alle großen Konzerne wie Microsoft, Amazon und Google auf Atomstrom setzen und neue Reaktoren ans Netz bringen.

Was meint ihr: Ist es sinnvoll, höflich zu ChatGPT zu sein, oder sollten wir aus Umweltgründen auf „Bitte“ und „Danke“ verzichten? Habt ihr selbst schon darüber nachgedacht, wie viel Energie eure Interaktionen mit KI verbrauchen? Teilt eure Gedanken in den Kommentaren!

Zusammenfassung

- Höfliche Formulierungen in ChatGPT-Anfragen kosten OpenAI viel Geld

- Zusätzliche Wörter erhöhen den Energieverbrauch in Rechenzentren

- Sam Altman: OpenAI verliert ‚zig Millionen Dollar‘ durch Höflichkeit

- Zwei Drittel der US-Nutzer sind freundlich zu KI-Chatbots

- KI-Nutzung verursacht hohe ökologische Kosten und Wasserverbrauch

- Ingenieure arbeiten an energieeffizienteren KI-Technologien

- Konzerne planen den Einsatz von Atomstrom für KI-Rechenzentren

Siehe auch: