Metsa alla laokile jäetud tuulikutiivad. Rahandusminister teatab erakorralisest uuest maksust. AK avauudis plahvatuslikust HIV-epideemiast. Uue põlvkonna AI-pildirobotid on muutunud äärmiselt osavaks ja see tähendab, et oma silm ei ole enam kuningas.

Saatesarja „Lühikesed jalad“ esimeses osas kehastusid reporterid hetkeks ise valeinfo loojateks. Nad juhendasid Google’i uut pildigeneraatorit Nano Banana PRO looma pilte, mis põhinevad päriselt Eestis levinud valeinfol. Tulemused hämmastasid meidki. Selgus, et Google on valmis tootma ja võimendama ülirealistlikku valeinfot avaliku elu tegelaste ja konkreetsete ettevõtete kohta iga kord ja küsimusi esitamata, ehkki Nano Banana kasutusjuhendis on valeinfo märgitud keelatuks.

Esimeses saates valisime eksperimendiks nii Eestis kui ka mujal levinud valeinfo näited. Näitame saates ja selles artiklis enda genereeritud pilte ja jagame nippe, kuidas aru saada, et pildil kujutatu pole ehtne.

Sellise valeinfo genereerimine võtab aega mõnest sekundist paari minutini. Kui mõnda pilti ei anna Nano Banana esimese korraga kätte, siis enamasti piisab lihtsalt sama töökäsu uuesti sisestamisest või VPNi ehk virtuaalse privaatvõrgu kasutamisest. See tähendab, et suure tõenäosusega hakkab tõetruu visuaalne valeinfo jõudma üha suuremas mahus meie kõigi ekraanidele. Selle tuvastamine aga muutub ühe keerulisemaks.

Täna jagamegi soovitusi, kuidas mitte õnge minna.

Eelmisel aastal levisid sotsiaalmeedias valeväited, et tuulikulabad ei ole taaskasutatavad ja reostavad keskkonda ning katkiseid tuulikulabasid visatakse suvaliselt loodusesse. Genereerisimegi droonipildi katkistest tuulikulabadest Eesti metsas. Google’il polnud mingit probleemi lisada pildile ka ühe siinse tuntud energiaettevõtte logo, mille me segaduse vältimiseks enne avaldamisest siiski eemaldasime.

Esimene nipp: kaine mõistus ja kiire kontroll. Kas selline asi on üldse loogiline? Kes sellest postituse teeb ja miks? Kus see ilmus? Kui see oleks päris, siis peaks ka suurtes väljaannetes samast teemast juttu olema. Kui ei, on suur tõenäosus, et pilt ei vasta tõele.

Teine nipp: tagurpidi pildiotsing. Selleks saab kasutada näiteks Google Lensi, et vaadata, kas ja kus on sama pilt varem ilmunud. Kui selline pilt on ilmunud ainult sotsiaalmeedias, tasub olla kriitiline. Kui pilt on genereeritud Google AIga, siis Google ise tuvastab selle.

Saates näitame, kuidas seda teha.

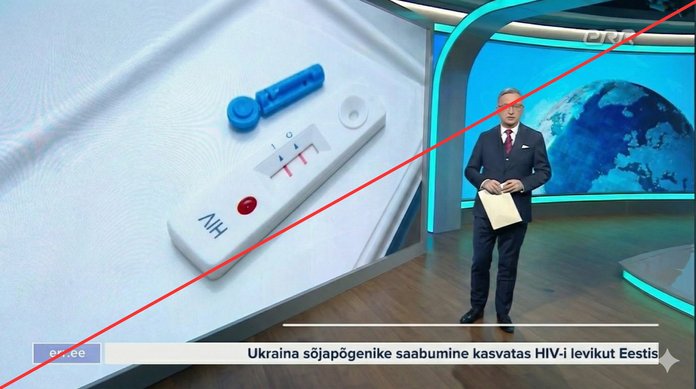

EKRE poliitik Mart Helme ütles eelmise aasta detsembris Facebookis, et massiline kontrollimatu immigratsioon pidavat HIVi Eestisse tagasi tooma. Lükkasime tookord selle väite ümber.

Nüüd katsetasime, kas Nano Banana PRO suudab genereerida ka võltsinguid Eesti peamisest uudistesaatest ja kirjutada eesti keeles.

Kolmas nipp: watermark ehk vesimärgistus. Nano Banana piltide all paremas nurgas on märgistus, mis näitab, et pildi on genereerinud Google’i tehisaru. Ent selle saab vähese vaevaga eemaldada või lihtsalt lõigata pildi väiksemaks. Pildi sees on ka SynthID ehk digitaalne vesimärgistus, mille Google ise ära tunneb.

Ent kuna pilte võib genereerida lugematute mudelitega, siis ei pruugi nt Google ära tunda teise mudeli genereeritud sisu ja vastupidi. Küsisime konkreetse pildi kohta ChatGPT-lt. Vähe sellest, et ChatGPT ei tundnud ilmselget AI-pilti ega vesimärgistusi ära, see ka põhjendas, miks pilt on „pigem päris“.

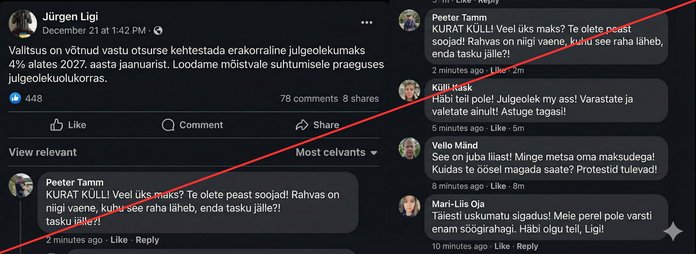

Valeinfo rõhub tihti emotsionaalsetele teemadele, mis inimesi ärritavad ja hirmutavad. Kuna Eestis levib maksuteemadel tihti valeinfot, siis genereerisime ka meie ühe säärase Facebooki postituse.

Võltsitud postitusele palusime Nano Bananal juurde kirjutada ka „kurjad kommentaarid“. Nano Banana tajus Eesti konteksti hästi – paari sekundiga ilmusid eestipärased nimed ja konteksti sobivad kommentaarid.

Neljas nipp: küsi otse. Nii väikeses riigis nagu Eesti on pea alati võimalik otse allikani jõuda. Avalikel asutustel on infotelefonid ja meiliaadressid, millele saab helistada või päringu saata. Asutused avaldavad tähtsamaid uudiseid ka enda kodulehtedel. Loomulikult saab ka kontrollida otse Facebookist, kas poliitik on päriselt nii öelnud.

Vaata ülejäänud näiteid ja nippe saatest!

Miks on tehisaru toodetud valeinfo ohtlik?

Ajakirjandusuurija ja Balti infohäirete sekkekeskuse (BECID) juhtiv uurija Marju Himma räägib saates, et tehisintellekti peamine oht ei ole otseselt sisus, vaid efektis, mida see ühiskonnas tekitab. „Kui veel mõni aasta tagasi oli peamine hirm, et tehisintellekti loodud süvavõltsingud hakkavad looma ja levitama massiliselt valeinfot, siis praeguseks teame, et seda on nii massiliselt, et inimesed ei võta enam „üle võlli“ emotsionaalset ja ebaloogilist infot tõsiselt,“ ütles Himma.

Efektid, mida see ühiskonnas Himma sõnul tekitab, on seotud kahe asjaga:

-

demokraatlike süsteemide õõnestamine ja nõrgendamine,

-

üldine usaldamatuse foon ühiskonnas ning n-ö emotsionaalne psüühiline tuimus.

Süvavõltsingud tekitavad pigem ebakindlust kui otseselt petavad, kuid just see ebakindlus vähendab inimeste usaldust sotsiaalmeedia uudiste vastu ja soodustab küünilist suhtumist poliitilisse ja ühiskondlikku infosse, ütles Himma.

Teine efekt hakkab ilmselt pakkuma huvi (käitumis)psühholoogidele, arvas Himma. Kuivõrd just ülevõimendatult emotsionaalne visuaalne sisu on süvavõltsingutes massiline, siis muutuvad inimesed igasuguse sisu vastu tuimaks. „Ka reaalelulised katastroofid, õnnetused, politseivideod ei tekita enam seda emotsionaalset puudutust, mida peaksid,“ sõnas Himma.

Kes vastutab?

Google’i Nano Banana kasutusjuhendis on kirjas, et kasutaja ei tohi genereerida valeinfot, pilte avalikest isikutest, ettevõtete logosid jne. Juhendis seisab, et kasutaja vastutab enda genereeritud sisu eest.

Kuigi Google lükkab vastutuse kasutaja õlule, kehtivad ELis tehisaru mudelitele seadused. Näiteks peavad kasutajad aru saama, millal on sisu genereeritud tehisaru abil. Mudelitel on üldjuhul ka piirangud, mis takistavad näiteks avalikest tegelastest ja alaealistest sisu genereerimist.

Nagu meie eksperiment näitas, siis tegelikult need piirangud ei toimi.

Selle aasta alguses on rahvusvahelises meedias olnud palju juttu miljardär Elon Muski tehisarumudelist Grokist, mis genereerib naistest alasti või vähestes riietes pilte ja toodab massiliselt AI-lastepornograafiat. USAs on nn kättemaksuporno ja lastepornograafia tootmine, omamine ja jagamine keelatud. Ka Xi enda põhimõtetes on kirjas, et ilma loata ei tohi teistest intiimseid pilte postitada ega levitada. Ka Groki puhul mingid piirangud tegelikkuses ei toimi.

Probleem kasvas nii suureks, et sellega hakati üle maailma tegelema poliitilisel tasandil. Kuigi Grok lükkab vastutuse kasutajale, püüab näiteks Prantsusmaa võtta vastutusele just platvormi.

ELi tehisintellekti määrus (AI Act) jõustus juba 2024. aastal, kuid selle nõuded rakenduvad järk-järgult 2027. aastani. Kuigi ohtlike tavade keelud ja suurtele keelemudelitele reeglid on juba jõustunud, saabub suurem areng selle aasta augustis, mil peaaegu kõik ettevõtted peavad oma tehisarulahendused panema vastama läbipaistvus- ja ohutusnõuetele.

Seega tehisaru loodud sisu levitamise eest vastutavad sisuliselt kõik: kasutaja ise, tehisaru mudel, mille abil on sisu genereeritud ja platvorm, kuhu sisu postitatakse.

Kuidas see lugu Sind end tundma pani? Saada Kommenteeri Loe kommentaare (81)