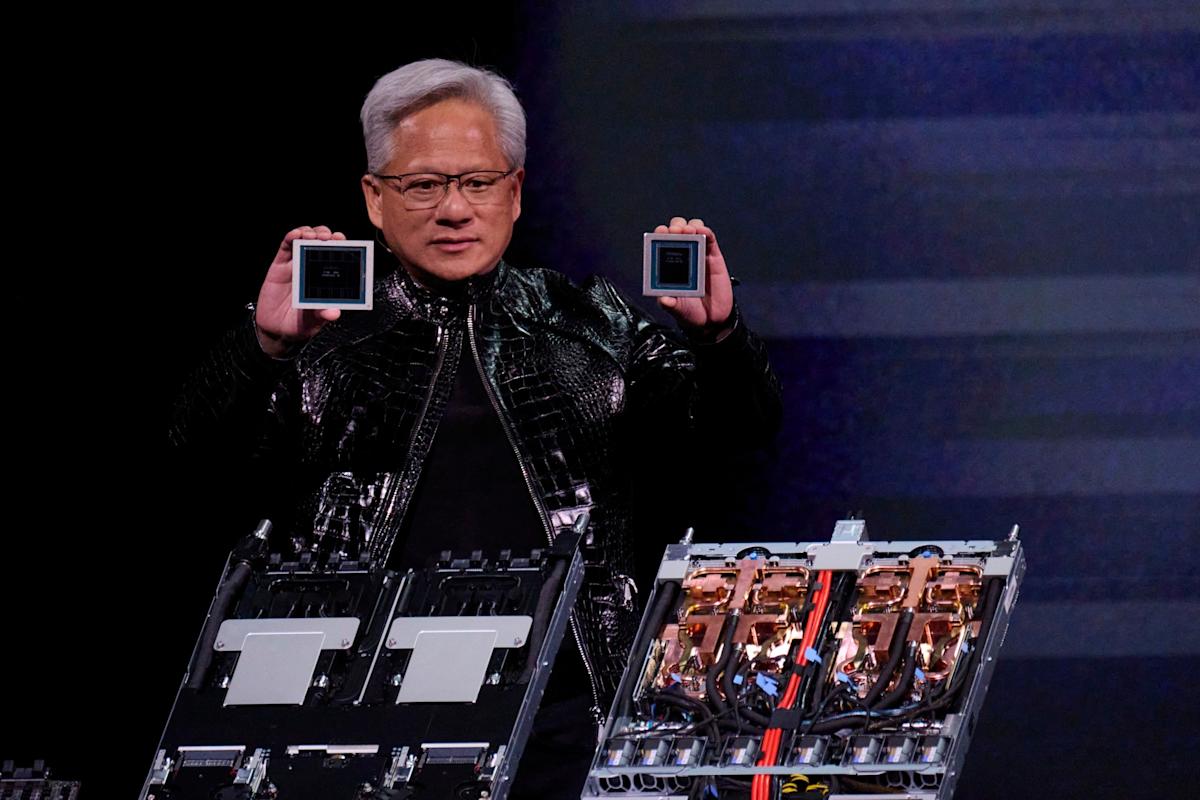

Foto: Bridget Bennett/Bloomberg

(Bloomberg) — El director ejecutivo de Nvidia Corp., Jensen Huang, dijo que los esperados procesadores Rubin para centros de datos de la compañía ya están en producción y que los clientes pronto podrán probar la tecnología.

aquí WhatsApp

Lo más leído de Bloomberg

Los seis chips de una nueva generación de equipos informáticos —que llevan el nombre de la astrónoma Vera Rubin— ya regresaron de los socios de manufactura y avanzan según lo previsto para su despliegue por parte de los clientes en el segundo semestre del año, dijo Huang el lunes en la feria CES en Las Vegas.

“La demanda es realmente alta”, dijo. La creciente complejidad y adopción del software de inteligencia artificial está ejerciendo presión sobre los recursos informáticos existentes, lo que crea la necesidad de muchos más, agregó Huang.

Las acciones subieron 2% hasta US$191,86 en Nueva York el martes. Han avanzado alrededor de 28% en el último año.

VER: Los esperados procesadores Rubin de Nvidia ya están en producción y pronto los clientes podrán probar la tecnología, dijo el director ejecutivo Jensen Huang. Masahiro Wakasugi, de Bloomberg Intelligence, analiza la situación (video en inglés).Fuente: Bloomberg

Nvidia, con sede en Santa Clara, California, busca mantener su ventaja como el principal fabricante de aceleradores de inteligencia artificial, los chips que utilizan los operadores de centros de datos para desarrollar y ejecutar modelos de IA.

Algunos en Wall Street han expresado preocupación por el aumento de la competencia para Nvidia y por la posibilidad de que el gasto en IA no pueda continuar a su ritmo actual. Los operadores de centros de datos también están desarrollando sus propios aceleradores de IA. Sin embargo, Nvidia ha mantenido previsiones optimistas a largo plazo que apuntan a un mercado total de billones de dólares.

Rubin es el acelerador más reciente de Nvidia y es 3,5 veces mejor para entrenar y cinco veces mejor para ejecutar software de IA que su predecesor, Blackwell, según la compañía. Una nueva unidad central de procesamiento tiene 88 núcleos —los principales elementos de procesamiento de datos— y ofrece el doble de rendimiento que el componente al que reemplaza.

La compañía está ofreciendo detalles de sus nuevos productos antes de lo habitual en el año, como parte de un impulso para mantener a la industria enfocada en su hardware, que ha respaldado una explosión en el uso de la IA. Nvidia suele profundizar en los detalles de sus productos en su evento GTC de primavera en San José, California.

Incluso mientras promociona nuevas ofertas, Nvidia dijo que las generaciones anteriores de productos siguen funcionando bien. La compañía también ha observado una fuerte demanda de clientes en China por el chip H200, que la administración Trump ha dicho que considerará permitir que el fabricante envíe a ese país.

Las solicitudes de licencia ya se han presentado y el gobierno de Estados Unidos está decidiendo qué hará con ellas, dijo la directora financiera Colette Kress a los analistas. Independientemente del nivel de aprobación de licencias, afirmó Kress, Nvidia tiene suficiente oferta para atender a los clientes en la nación asiática sin afectar su capacidad de enviar productos a clientes en otras partes del mundo.

Para Huang, el CES es otra parada más en su maratón de apariciones en eventos, donde ha anunciado productos, alianzas e inversiones, todo con el objetivo de sumar impulso al despliegue de sistemas de IA. Su contraparte en el rival más cercano de Nvidia, Lisa Su, de Advanced Micro Devices Inc., realizó la presentación principal en la feria más tarde el lunes.

El nuevo hardware, que también incluye componentes de redes y conectividad, formará parte de su supercomputadora DGX SuperPod y también estará disponible como productos individuales para que los clientes los utilicen de forma más modular. El aumento de rendimiento es necesario porque la IA ha pasado a redes de modelos más especializadas que no solo analizan enormes volúmenes de datos, sino que deben resolver problemas específicos mediante procesos de múltiples etapas.

La compañía subrayó que los sistemas basados en Rubin serán más baratos de operar que las versiones Blackwell porque ofrecerán los mismos resultados utilizando una menor cantidad de componentes. Microsoft Corp. y otros grandes proveedores de computación remota estarán entre los primeros en desplegar el nuevo hardware en el segundo semestre del año, dijo Nvidia.

Por ahora, la mayor parte del gasto en computadoras basadas en Nvidia proviene de los presupuestos de gasto de capital de un grupo reducido de clientes, incluidos Microsoft, Google Cloud de Alphabet Inc. y AWS de Amazon.com Inc. Nvidia está impulsando software y hardware destinados a ampliar la adopción de la IA en toda la economía, incluidos la robótica, la atención de la salud y la industria pesada.

Como parte de ese esfuerzo, Nvidia anunció un conjunto de herramientas diseñadas para acelerar el desarrollo de vehículos autónomos y robots.

Nota Original: Nvidia CEO Says Rubin Chips Are on Track, Demand Is Strong (2)

MÁS CONTENIDO EN ESPAÑOL:

-

Suscríbase aquí al boletín Cinco Cosas

-

Bloomberg en español está en LinkedIn

-

Conozca nuestro canal de WhatsApp

-

Usuarios terminal: vea la versión español de Daybreak en DAYB

©2026 Bloomberg L.P.