Los rumores sobre los próximos iPhone comienzan a tomar forma. Pese a que estamos a varios meses de la presentación oficial del iPhone 18, algunas filtraciones dejan entrever los planes de Apple para este y otros dispositivos. Uno de ellos tiene que ver con la cámara, de la cual se rumorea que incluirá una nueva tecnología que llevará al siguiente nivel la fotografía de retrato.

No es un secreto que Apple está en una etapa de reestructuración que contempla nuevos dispositivos y un enfoque hacia la IA. Aunque la mayoría de los cambios están orientados a evitar fracasos como Siri con Apple Intelligence o el Vision Pro, la compañía también considera ajustes en la cadena de producción. Esto la ha llevado a diversificar la lista de proveedores para obtener nuevas tecnologías que se aplicarán a iPhone del futuro.

Sumado a la cámara de 200 megapíxeles de Samsung, Apple ha mostrado interés en sensores multiespectrales. De acuerdo con el conocido filtrador Digital Chat Station, el gigante tecnológico ya se puso en contacto con los proveedores, aunque todavía no comienza a probarlos.

¿Qué son los sensores multiespectrales y cómo mejorarían las fotos del iPhone?

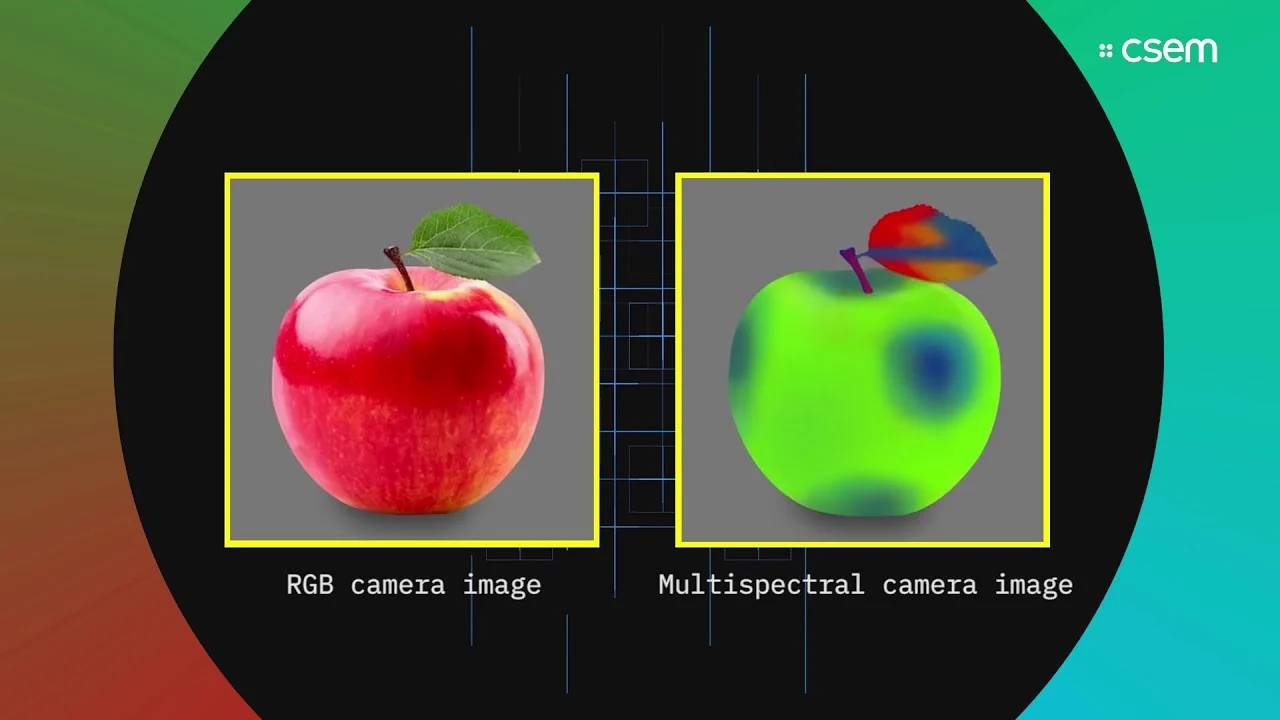

Estos sensores, desarrollados originalmente para las imágenes satelitales, pueden capturar información en múltiples rangos del espectro electromagnético. Las imágenes registran el infrarrojo, ultravioleta y otras longitudes de onda que no son visibles para el ojo humano. Comparados con los sensores RGB tradicionales, los multiespectrales incluyen más datos, lo que daría como resultado mejores fotografías con la cámara del iPhone.

En términos de funcionamiento, los sensores multiespectrales cuentan con filtros que captan una banda distinta. Posteriormente, el sistema fusiona estas bandas y utiliza algoritmos para interpretar los datos, los cuales servirán para mejorar valores como color, contraste o detalle en las fotos.

Comparación entre un sensor RGB y un sensor multiespectral. Imagen CSEM.

Comparación entre un sensor RGB y un sensor multiespectral. Imagen CSEM.

Si tomas una fotografía de retrato con el iPhone, el sensor multiespectral ofrecería una mayor diferenciación de los matices de la piel, reduciendo los tonos rojizos o verdosos. También permitirían reconstruir detalles en condiciones de poca iluminación o conservar algunos cuando haya mucha luz. Al combinar múltiples espectros, la cámara del iPhone tendría más información sobre luces y sombras, acabando así con las fotos con ruido o «quemadas».

Los sensores multiespectrales también ayudan a distinguir otros elementos de la persona, como la piel o el cabello, consiguiendo un desenfoque más preciso para separar el sujeto del fondo.

Actualmente, estos sensores se utilizan en drones, cámaras científicas y gafas de visión nocturna. Los científicos ambientales las aprovechan para estudiar los suelos, el agua o la vegetación, gracias a su capacidad para diferenciar los materiales. En el campo de los smartphones, Apple no es la única que estudia su integración, ya que Oppo y Huawei exploran tecnologías similares para mejorar la fotografía de sus móviles.

Apple pisa el acelerador para mejorar las cámaras del iPhone

Los reportes sobre sensores multiespectrales o una cámara de 200 megapíxeles se encuentran en calidad de rumor. El filtrador chino afirma que el sensor de Samsung está en fase de pruebas, mientras que analistas señalan que esta tecnología tardará en llegar.

Es probable que tengamos que esperar a 2027 o 2028 para ver un iPhone con una cámara tan potente que sea capaz de entregar fotografías de retrato más detalladas. Antes de hacer cualquier cambio, los ingenieros de Cupertino tienen que optimizar el Photonic Engine para que el procesamiento y almacenamiento de estas fotos sea manejable por el hardware del dispositivo.