En los últimos años, la neurotecnología y la inteligencia artificial han convergido en aplicaciones que van del tratamiento de secuelas de accidentes cerebrovasculares a la modulación de la actividad neuronal. En este contexto, el trabajo del doctor José Luis Contreras Vidal, profesor distinguido en la Universidad de Houston y director del BRAIN Center —parte del programa IUCRC (Industry-University Cooperative Research Centers) de la Fundación Nacional de Ciencias (NSF, por sus siglas en inglés)—, ha contribuido a crear interfaces cerebro-máquina que muestran el potencial de esta tecnología.

Dentro del marco del WIRED Summit 2025: The Big Interview presentado por Nissan en colaboración con Airbnb, WIRED en Español conversó con el neurocientífico mexicano sobre su investigación en interfaces cerebro-máquina, el papel de la electroencefalografía (EEG) en su desarrollo, sus aplicaciones actuales y venideras, y su relación con las artes y el desarrollo humano.

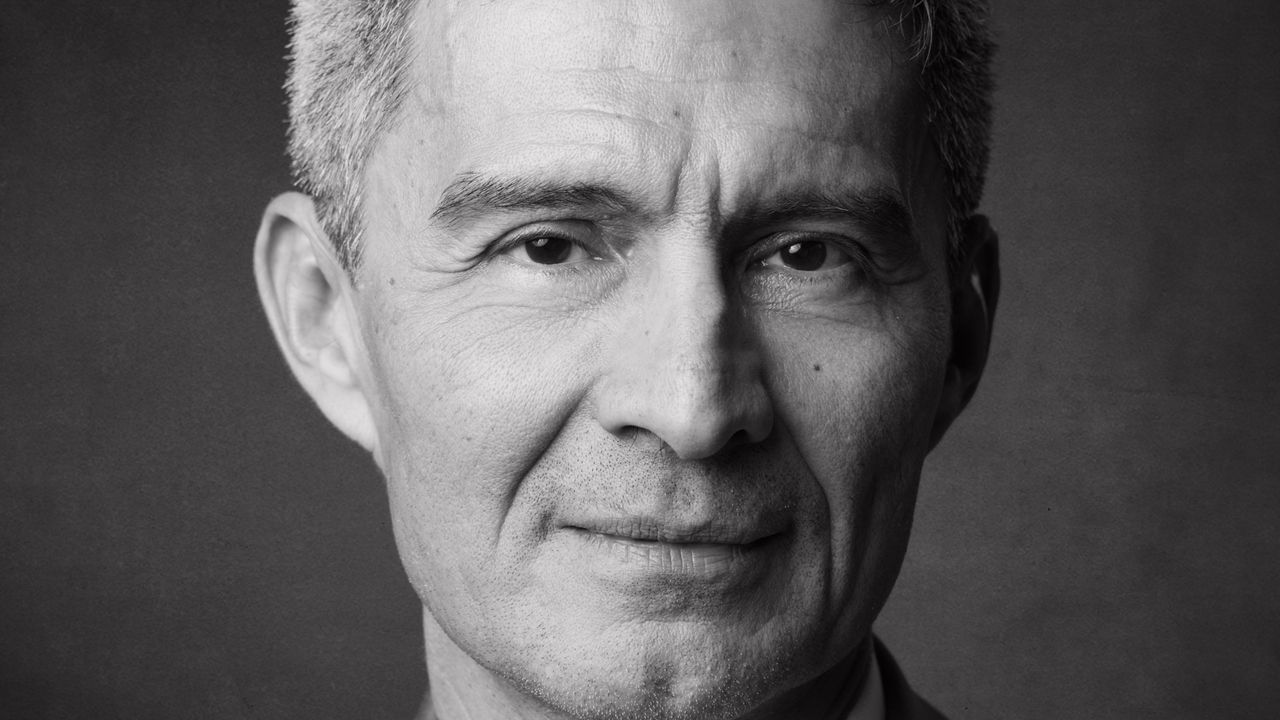

“La primera vez que un participante usó un exoesqueleto robótico controlado por BCI, llegué al laboratorio y lo vi sonriendo”.

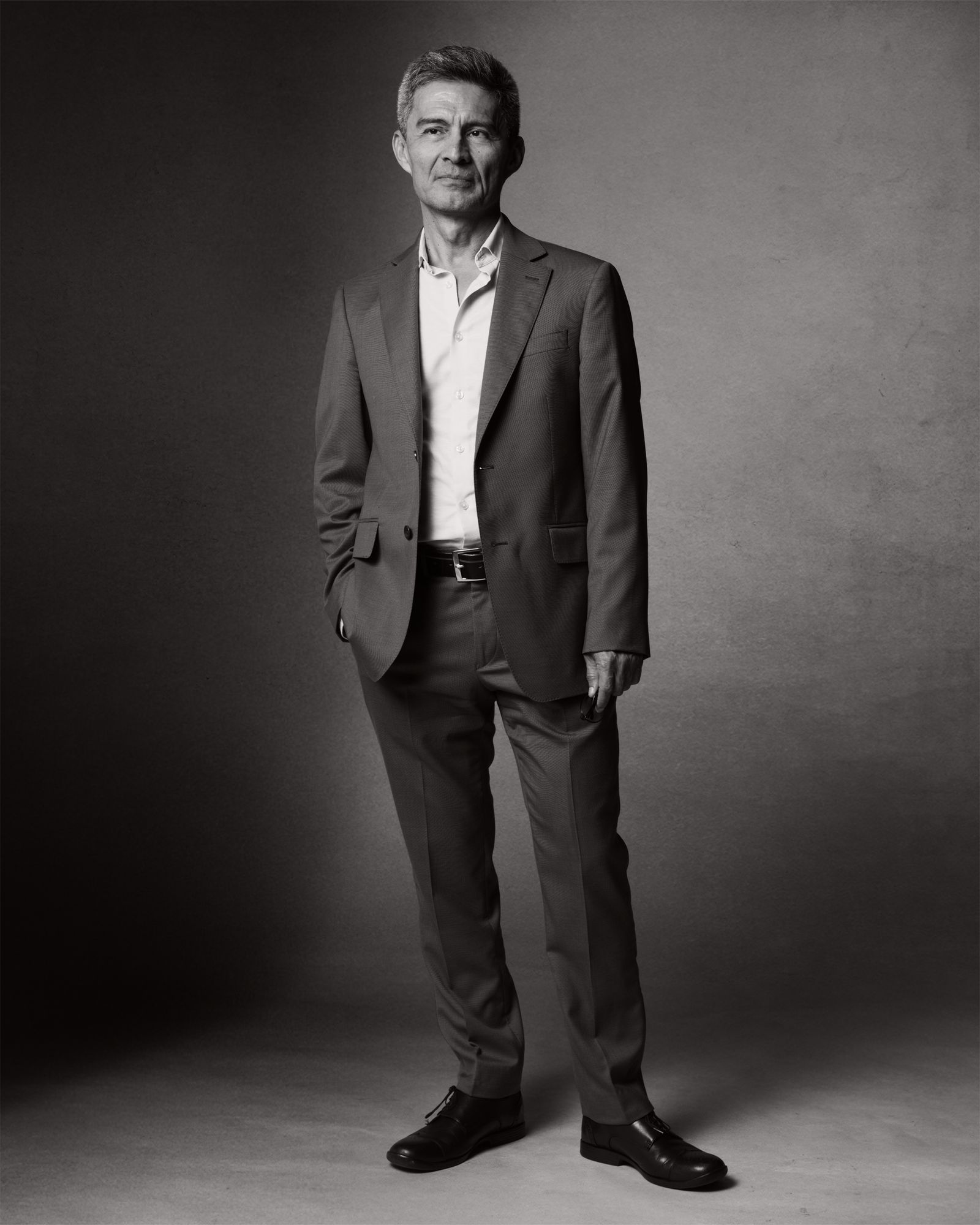

Dr. José Luis Contreras Vidal

El Dr. Contreras Vidal lideró la primera evaluación integral de integración del conocimiento sobre el estado global de los ensayos clínicos de interfaces cerebro-computadora implantables (iBCI).

José Carlos Martínez

Esta entrevista ha sido editada para mejorar su lectura.

WIRED: ¿Cómo describirías tu trabajo en el desarrollo de interfaces cerebro-máquina a alguien que no sabe nada del tema?

José Luis Contreras Vidal: Un sistema de interfaz cerebro-máquina (BCI), en lo más básico, es un canal directo de comunicación o control entre tu cerebro y el entorno digital o físico. Imaginen que piensan en caminar y tenemos sensores —implantados o superficiales— que detectan la actividad cerebral relacionada con ese pensamiento. Si cuentas con un buen modelo de aprendizaje que capte ese pensamiento, esa señal puede enviarse al exterior para activar un robot, un manipulador o una computadora.

Según Contreras Vidal, un BCI usualmente comprende cuatro etapas: un dispositivo registra la actividad, se limpian artefactos (señales externas o fisiológicas que contaminan la información), se decodifica la señal y se envía —generalmente de forma inalámbrica— para controlar un dispositivo (por ejemplo, un brazo robótico).

WIRED: En 2010, tú y tu equipo mostraron que la tecnología tenía más capacidades de lo imaginado. ¿Qué se pensaba imposible y qué demostraron?

JLCV: Estas señales se alteran por artefactos. Cada vez que parpadeas hay una señal fuerte detrás de los ojos que contamina la señal cerebral. Al hablar, los músculos generan señales eléctricas que también contaminan. Durante mucho tiempo se pensó que era imposible extraer una señal clara con sensores superficiales. Pero alrededor de 2010 demostramos por primera vez que es posible decodificarlas si sigues una receta particular.

El primer punto de esta receta es que tienes que escuchar todo el cerebro, toda la sinfonía neuronal. Imagínense que van a un concierto en el estadio y ya no hay tickets, y tienen que escucharlo desde afuera. Lo pueden escuchar, quizá la calidad va a ser menor, pero están escuchando. Entonces es una analogía, nosotros estamos escuchando lo que está pasando adentro, pero no podemos tener una especificidad local.

La segunda parte de esta receta es cómo el cerebro codifica la intención y mis colegas anteriormente se habían enfocado en el dominio de la frecuencia. Por ejemplo, el número de oscilaciones por segundo en diferentes bandas, se imaginan si tienen todavía un radio en su coche, tienen estaciones de AM y FM, se enfocan más en los de FM, variaciones en la modulación en base a la frecuencia. Y nosotros lo que encontramos es que con EEG tienes que ir a AM, en modulación de la amplitud.