Ya se ha hablado mucho de la memoria HBM, e incluso de la HMC, que puede tener significativas ventajas frente a la RAM convencional por su mayor ancho de banda, especialmente en HPC y cargas de IA. Sin embargo, hoy te traemos un término novedoso, como es HBM-on-GPU, un concepto que permite aprovechar aún más las capacidades de esta memoria.

¿Qué es HBM-on-GPU?

Como ya sabes si nos lees, la HBM (High Bandwidth Memory) es un tipo de memoria DRAM apilada en 3D, diseñada para ofrecer un ancho de banda muy superior al de memorias tradicionales como GDDR5/6, y por supuesto mucho más que la DDR convencional. Gracias a ellos se usa como memoria VRAM o para aceleradores de IA, entre otros proyectos de HPC.

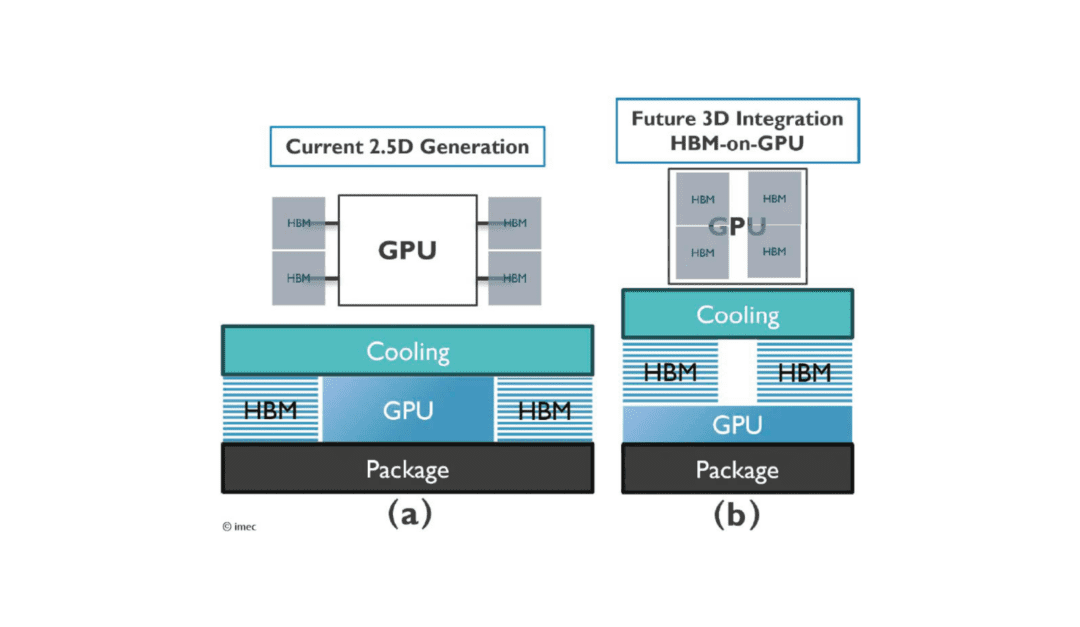

Por otro lado, GPU ya sabes que se refiere a Graphics Processor Unit, es decir, la unidad de procesamiento gráfico. Por tanto, si unimos ambos conceptos hablamos de HBM-on-GPU, es decir, la integración física de los chips HBM en el mismo sustrato que la GPU, conectados mediante un interposer de silicio y vías verticales (TSV). Esto elimina cuellos de botella y reduce la distancia entre procesador y memoria en comparación con los sistemas que implementan los chips HBM alrededor de la GPU en una PCB.

En la imagen superior puedes ver un diseño del imec donde se aprecia el diseño A, en el que se incluye un modelo más convencional como los vistos hasta ahora en Intel, AMD o NVIDIA, donde hay un chip GPU de cómputo en el centro y chips HBM de memoria rodeando al chip de cómputo, muy cerca, pero conectados mediante un PCB. En cambio, el diseño B es HBM-on-GPU, y vemos que los chips se apilan sobre la GPU, conectando a ésta con las pilas HBM mediante TSV. Es decir, algo parecido a lo que hace AMD con su 3D V-Cache…

Te puede interesar conocer sobre las mejores GPUs actuales

Ventajas principales

Entre las ventajas principales de este nuevo concepto, y que nos puede recordar en cierto sentido a la C-RAM, hay que destacar las siguientes:

- Mayor ancho de banda: HBM puede alcanzar cientos de GB/s por stack, superando ampliamente a GDDR. Incluso se puede llegar a varios TB/s de transferencia con una gran eficiencia y bajas latencias.

- Eficiencia energética: al estar físicamente cerca de la GPU, los datos recorren menos distancia, reduciendo consumo.

- Factor de forma compacto: al apilar chips verticalmente, se logra más capacidad en menos espacio, ideal para tarjetas gráficas de alto rendimiento.

- Reducción de latencia: la proximidad física entre GPU y memoria mejora tiempos de acceso frente a sistemas donde los chips HBM están en un PCB para conectarlos a la GPU.

- Escalabilidad para IA y HPC: permite manejar datasets masivos en aplicaciones de inteligencia artificial, simulaciones científicas y supercomputación.

Desventajas

Para finalizar, como todo, este concepto también tiene sus puntos negativos, no todo son ventajas. HBM-on-GPU tiene:

- Coste elevado: la fabricación de HBM y su integración en el mismo encapsulado es más cara que GDDR.

- Complejidad de diseño: requiere interposers de silicio y técnicas avanzadas de empaquetado 3D, lo que encarece aún más el diseño.

- Disponibilidad limitada: se usa principalmente en GPUs profesionales y de centros de datos, dado los anteriores puntos.

- Disipación de calor: al estar apilados, la disipación de calor resulta menos eficiente que en diseños planos, por lo que puede verse limitada su frecuencia de reloj o necesitar de sistemas de refrigeración más avanzados.

- Capacidad: la HBM tiene limitaciones sobre la capacidad debido a la dependencia de las pilas de DRAM frente a la GDDR, por lo que la capacidad puede verse más limitada.

No olvides comentar tus dudas o sugerencias al respecto…