Yksi suurimmista tekoälyfirmoista, Perplexity, kieltäytyy noudattamasta verkkon yhtä ”pyhintä” sääntöä eli sivustojen indeksoinnin kieltäviä ohjeita.

Perinteisesti jokainen verkkosivusto on voinut estää haluamansa botit sekä estää osia sivustostaan kokonaan boteilta. Tähän on käytetty robots.txt -tiedostoa, joka löytyy lähes kaikkien maailman verkkosivujen juuresta.

Kyseisen pienen tekstipätkän avulla verkkosivustot ovat voineet kertoa vaikkapa Googlelle, että joitain osia sivustosta ei saa käydä Googlen toimesta lainkaan läpi ja kyseisiä osioita ei saa myöskään lisätä Googlen hakuun.

Tätä periaatetta on kunnioitettu jo vuosikymmenten ajan, vaikka se tarkoittaa joskus hakukoneille harmillisia, tärkeiden sisältökokonaisuuksien puuttumisia niiden hakukoneesta.

Esimerkiksi maailman suurin keskustelualue Reddit on voinut luottaa tähän ”lupaukseen”, että sen sivuilla oleva robots.txt sallii sivuston indeksoinnin vain Googlelle eikä kenellekään muulle. Yhtiö teki miljoonien arvoisen sopimuksen viime vuonna ja sallii sisältönsä näkyvän vain Googlen hakukoneessa.

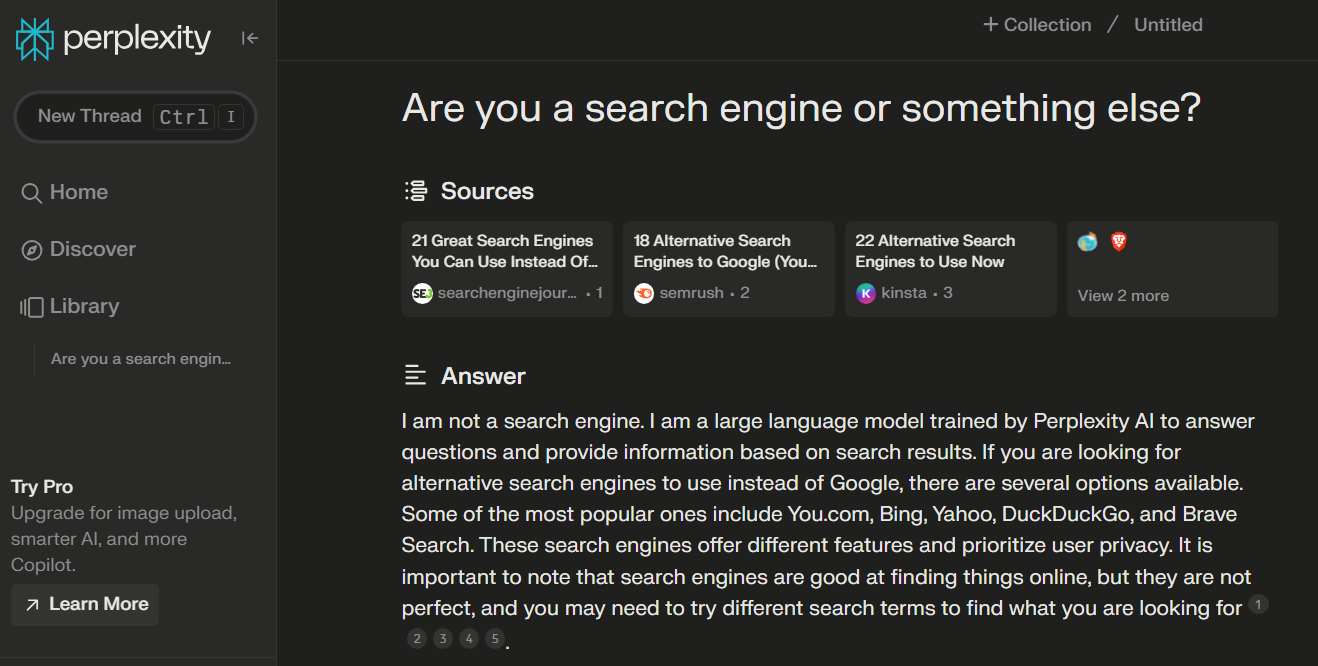

Mutta maailman suurimman verkkosivujen liikennettä suodattavan ja suojelevan yhtiön, Cloudflaren, mukaan Perplexity kieltäytyy noudattamasta mitään sääntöjä. Tekoälyhakukoneestaan tutun yhtiön botit eivät välitä lainkaan robots.txt -tiedoston säännöistä.

Lisäksi Cloudflaren havainnon mukaan, jos sivusto pyrkii aktiivisesti estämään Perplexityn botteja, naamioituu Perplexityn botti Chrome-selaimeksi, vaihtamalla tunnistetietojaan. Tämä on yleisesti ottaen erittäin huonoa käytöstä – ja saattaa rikkoa useimmissa tapauksissa verkkosivustojen asettamia käyttöehtoja.

Tekoälybottien sivustoille tuoma liikenne alkaa olemaan hyvin ongelmallista, sillä jokainen botin lataama sivu kuluttaa verkkosivuston resursseja.

Kuluttajat harvoin ymmärtävät sitä, että verkkosivustojen ylläpito ja niiden verkkoyhteydet maksavat rahaa. Keskisuurienkin sivustojen tapauksessa puhutaan jo varsin merkittävistä summista rahaa.

Tekoälybotit ovat tässä mielessä loiseläjiä, sillä ne imevät verkkosivustolta itselleen tietoa, mutta lähettävät äärimmäisen vähän varsinaisia, oikeita käyttäjiä takaisin sivustoille. Osa tekoälypalveluista ei lähetä lainkaan ihmisliikennettä sivustoille, eli niistä ei ole sivuston ylläpitäjien kannalta muuta kuin haittaa ja kuluja.

Esimerkiksi lahjoitusrahoilla ylläpidettävän Wikipedian kaikista sivulatauksista jopa 65% on nykyisin tekoälybottien tekemiä. Pienet, harrastuspohjalta pyöritettävät sivustot ovat jopa joutuneet sulkemaan kokonaan sivustonsa, kun niiden ylläpitokulut ovat kasvaneet räjähdysmäisesti tekoälybottien aiheuttaman liikenteen vuoksi.