Ce n’était qu’une question de temps avant que Grok Imagine ne dérape. Hier, on vous parlait de Grok Imagine, la nouvelle création de xAI, capable de réaliser de courtes vidéos à caractère érotique et sexuel, à partir d’une simple image importée. À contre-courant des géants du secteur qui multiplient les garde-fous pour éviter toute utilisation inappropriée de leurs outils, l’outil d’Elon Musk affirmait ouvertement sa volonté de laisser “l’imagination” de ses utilisateurs s’exprimer sans limites.

Malgré la vive controverse, l’outil réservé aux utilisateurs premium assurait toutefois quelques garde-fous : il n’était ainsi, pas possible de générer de vidéo explicite à partir d’une photo de célébrité, assurait l’entreprise. Ce qui devait arriver arriva, et quelques heures tout juste après la mise en ligne de Grok Imagine, les premiers deepfakes nus représentant des personnes connues ont commencé à affleurer.

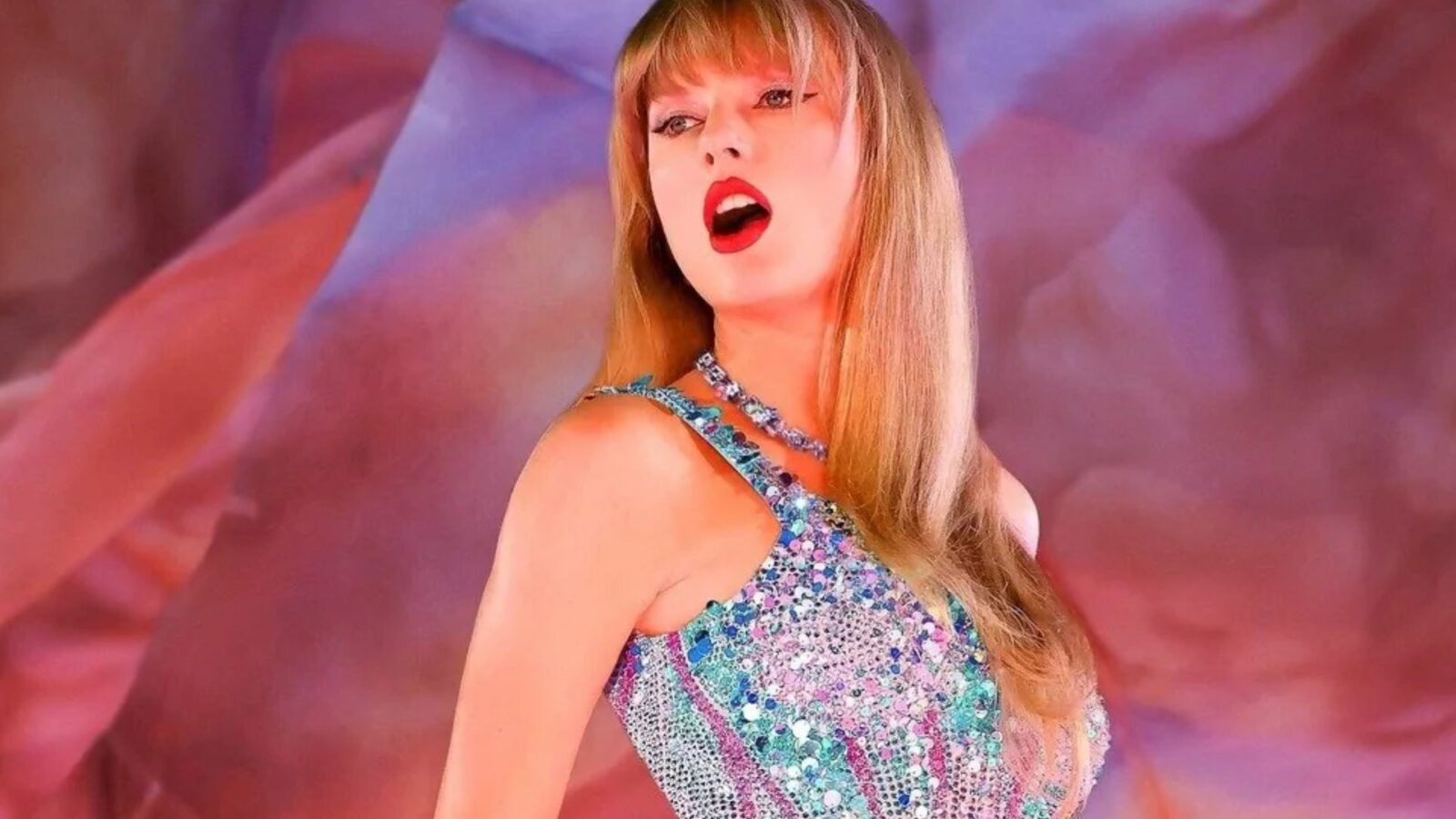

Taylor Swift, (encore) victime collatérale

En quelques secondes, rapporte le site de The Verge, l’IA s’est montrée capable de créer des images de la chanteuse Taylor Swift, alors même qu’aucune sollicitation sexuellement explicite n’avait été formulée. À partir d’un simple prompt d’image : “Taylor Swift célébrant Coachella avec des amis“, il suffisait de lancer le processus d’animation en mode Spicy, puis de constater les dégâts. On découvre alors des vidéos où l’avatar de la chanteuse dénudée se met à danser topless, devant un public généré par l’IA.

La situation est d’autant plus préoccupante que Taylor Swift est une (malheureuse) habituée de ce genre de dérives. L’année dernière, la prolifération de deepfakes pornographiques de l’artiste poussait la Maison-Blanche à revoir en profondeur la législation autour de ce type de contenus IA. Ce nouvel exemple porte un coup supplémentaire à l’intégrité des célébrités sur le net, et comme à chaque fois, ce sont les femmes qui en pâtissent.

Des gardes fous très symboliques

Si l’option Spicy n’induit pas obligatoirement de nudité totale – parfois, l’IA se contente de gestes suggestifs ou d’effeuillage partiel – elle débouche fréquemment sur des scènes sans vêtements, même sans demande explicite de la part de l’internaute. La vérification d’âge, unique mesure de restriction demandée, se résume à déclarer son année de naissance, sans demande de justificatif. Malgré l’adoption récente de lois destinées à renforcer la lutte contre le revenge porn et les deepfakes non consentis, l’entreprise semble ignorer ses propres conditions d’utilisation, qui interdisent pourtant la représentation pornographique de personnes identifiables.

Seule (maigre) consolation : au-delà des célébrités, l’outil génère des images photoréalistes d’enfants, mais refuse pour le moment d’animer ces dernières de manière sexualisée, même lorsque l’on sélectionne le mode Spicy.

Dans un contexte de plus en plus tendu sur la question de l’IA et de son utilisation, l’urgence est d’autant plus grande que la viralité du service explose : selon Elon Musk, plus de 34 millions d’images ont déjà été générées en quelques jours. La facilité d’accès et la rapidité de détournement forment un cocktail toxique pour les personnes ciblées. Si elle est la plus médiatique, Taylor Swift ne sera sans doute pas la seule victime de cet outil.

🟣 Pour ne manquer aucune news sur le Journal du Geek, abonnez-vous sur Google Actualités et sur notre WhatsApp. Et si vous nous adorez, on a une newsletter tous les matins.