L’évocation d’une possible ingérence russe dans les élections de juillet dernier à la Chambre des conseillers a fait l’objet de nombreuses discussions. Prouver sa réalité est ardu, mais des manipulations de l’information par la Russie ont été signalées à de nombreuses reprises en Europe.

Le 15 juillet dernier, pendant la campagne des élections à la Chambre des Conseillers (la chambre haute du Parlement), Yamamoto Ichirô, de l’Institut japonais du droit et des systèmes d’information, un organisme privé, a publié sur note [site japonais sur lequel chacun peut publier un article] un texte intitulé Le parti Sanseitô, et les élections japonaises manipulées par de fausses informations fabriquées en Russie.

Yamamoto a indiqué que des bots (c’est-à-dire des logiciels réalisant automatiquement des tâches) originaires de Russie diffusaient de fausses informations et se livraient des manipulations médiatiques visant le pouvoir politique japonais. Cinq comptes X mentionnés dans l’article ont été gelés le lendemain.

Les médias ont discuté de cette question après les élections. Dans des interviews à NHK, au quotidien Asahi Shimbun et à d’autres médias japonais, le gérant de Japan News Navi, un site dont Yamamoto avait indiqué qu’il diffusait des contenus créés par Sputnik Japon, un média affilié au gouvernement russe, a nié tout lien avec ce dernier. Certains des chercheurs contactés par des journalistes enquêtant sur ce sujet ont évoqué la possibilité d’une ingérence russe, d’autres ont parlé de buts financiers.

Cela n’a pas de sens de chercher à montrer que quelqu’un a intentionnellement diffusé de la propagande du gouvernement russe ou de fausses informations venant de Russie, d’une part parce que prouver l’existence de telles intentions est difficile, et d’autre part parce qu’un des aspects des manipulations d’influence auxquelles se livre la Russie est qu’elle rend possible la diffusion involontaire de telles informations émanant de ce pays.

Manipulations d’influence par des masses de comptes de trolls et de bots

Fin novembre 2024, Bruno Kahl, alors directeur du service fédéral allemand du renseignement, a tiré la sonnette d’alarme sur l’échelle massive et sans précédent des manipulations informationnelles russes, soulignant que ces attaques médiatiques étaient devenues un moyen essentiel de la nouvelle guerre informationnelle que mène Moscou, principalement pour affaiblir de l’intérieur ses ennemis.

Un des grands succès de ces efforts serait l’élection de candidats pro-russes en Géorgie, en France, et Moldavie ou encore en Roumanie.

Selon le Wall Street Journal, les opérations d’influences russes sur les réseaux sociaux se traduisent ces dernières années par la création d’un énorme nombre de comptes de « bot-trolls » (des bots qui se livrent à des actes de nuisance, notamment de la diffamation, sur internet) diffusant de la propagande russe en commentant les posts d’influenceurs ou de personnes célèbres. Ces bot-trolls attirent l’attention en se mêlant aux conversations en ligne d’influenceurs ayant de nombreux followers. Même un compte de création récente qui n’en a pas encore beaucoup a intérêt à émettre des informations sous une forme qui attire l’œil.

On assiste au même phénomène dans l’espace informationnel en langue japonaise. Je ne suis pas une influenceuse ni une personne célèbre, mais les mouvements de comptes d’origine russe que j’ai vus lorsque j’ai publié sur la plateforme X un contenu relatif aux opérations d’influence russes me l’ont clairement montré.

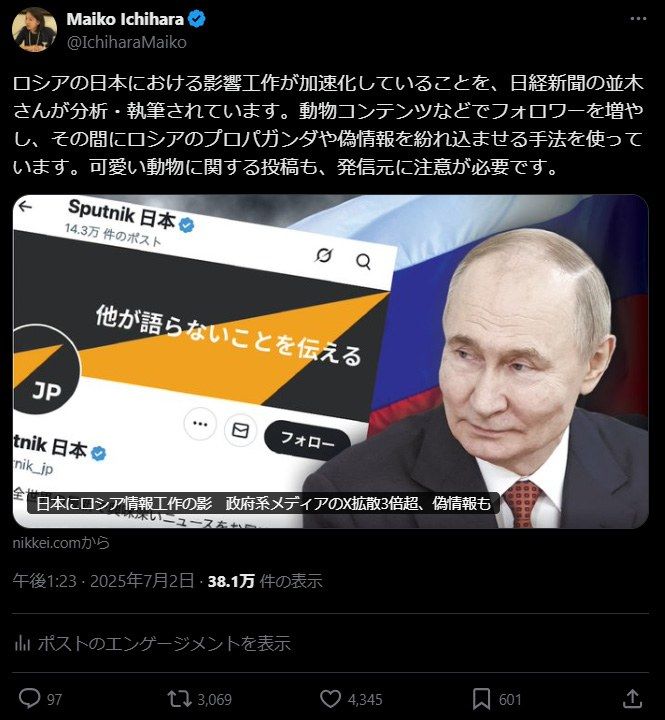

Le 2 juillet dernier, c’est-à-dire deux jours avant les élections à la Chambre haute, j’ai partagé sur X un article du quotidien Nikkei Shimbun concernant l’expansion de ces opérations au Japon. Mon compte X n’ayant qu’un peu moins de 5 000 followers, ma capacité de diffusion n’est pas très importante. Malgré cela, il y a eu 533 commentaires et citations (c’est-à-dire que le contenu a été reposté avec un commentaire).

Le post sur le compte X @IchiharaMaiko présentant l’article du quotidien économique (capture d’écran faite le 10 septembre 2025).

On peut considérer que les likes et le fait de re-tweeter sans commentaire mon post indiquent un accord avec le contenu, et une intention de le diffuser.

Mais parmi les commentaires accompagnant ces re-tweets, beaucoup exprimaient du mépris pour ma personne ou celle du journaliste auteur de l’article (par exemple « Des imbéciles qui ne savent que médire de la Russie »), ou niaient l’existence d’opération de manipulation de l’opinion et parlaient « de propagande contre la soi-disant propagande russe ».

J’ai enquêté pour établir quelle proportion de ces comptes ayant republié et commenté ce post, étaient d’origine russe.

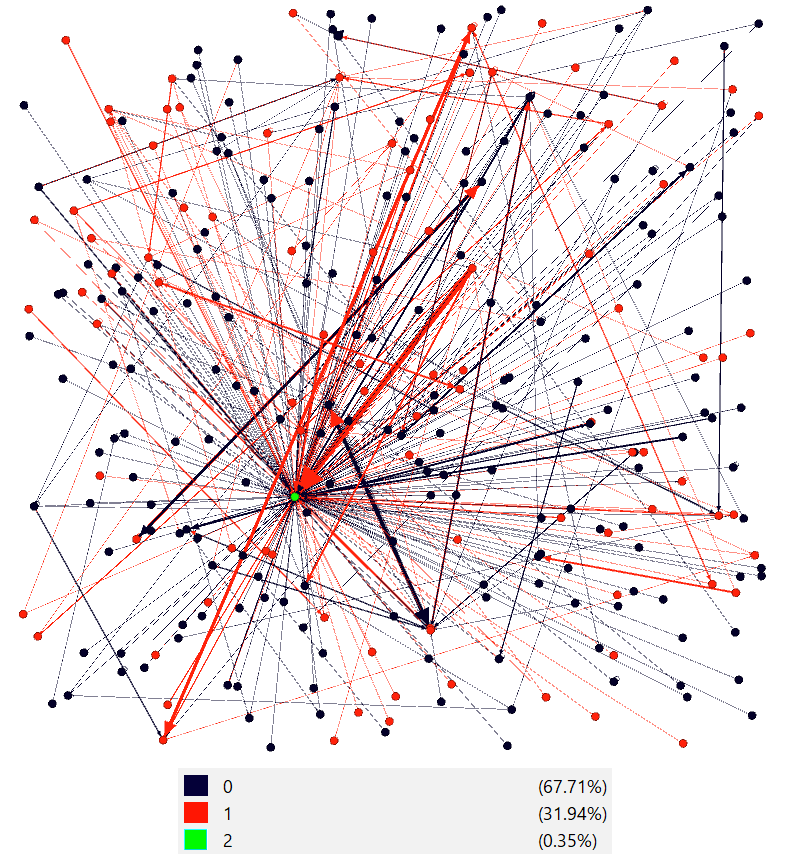

Je me suis d’abord intéressé aux liens avec des comptes de bot-trolls russes ou chinois pistés dans une enquête menée fin 2024 par DFRLab, un think tank américain spécialisé en politique internationale. En d’autres termes, j’ai vérifié s’ils étaient suivis par plusieurs des principaux comptes diffusant d’ordinaire le discours russe et chinois. Enfin, parmi les comptes ayant été suivis, j’ai fait une distinction entre ceux actifs dans l’espace discursif russe et chinois et ceux sans lien avec ces espaces.

Le diagramme ci-dessous montre le réseau ayant réagi à mon post. Les noyaux rouges indiquent les comptes considérés comme d’origine russe. Parmi ceux ayant reposté ou commenté mon post, environ 32 % des réactions émanaient de comptes d’origine russe, 92 au total, avec 218 repostages et commentaires vis-à-vis ceux-ci. De plus, comme les re-tweets de re-tweets effectuées par ces comptes ne sont pas compris sur le diagramme, le réseau destiné à diffuser les discours d’origine russe est en réalité encore plus grand.

Note : le point vert indique mon compte, les points rouges les comptes suivis par plusieurs des principaux comptes diffusant du discours chinois et russe et considérés comme étant actifs dans l’espace discursif russe. Les points noirs indiquent les autres comptes. Source : ce diagramme a été réalisé par l’auteure de l’article en utilisant le logiciel libre Gephi.

En juillet 2024, le Département américain de la Justice a identifié des comptes liés à des fermes de bots russe dans plus de mille cas. Alexa Corse, du Wall Street Journal, indique que la création de très nombreux comptes s’explique par l’objectif de permettre de continuer à diffuser des informations lorsqu’une partie des comptes créés précédemment sont éliminés. Ces comptes si nombreux ont assuré la diffusion de la propagande russe grâce à leurs commentaires qu’ils font sur des comptes d’influenceurs ou de personnalités connues.

Une initiative de l’administration Trump qui les aide

La fermeture récente par l’administration du Global Engagement Center, une agence fédérale américaine au sein du Département d’État, revient quasiment à soutenir les manipulations d’informations par la Russie. Cette agence avait pour mission d’enquêter sur les opérations russes et chinoise de désinformation, et de prendre des contre-mesures.

L’administration Trump a aussi mis fin à l’aide apporté par l’USAID aux médias indépendants des autres pays, ce qui a pour conséquence d’affaiblir les médias d’investigation de ces pays. Le financement de médias comme Voice of America, Radio Free Asia ou Radio Free Europe, qui diffusaient des informations cachées par la propagande des gouvernements autoritaires comme ceux de la Chine ou de la Russie, a aussi été arrêté.

L’assouplissement de la réglementation des plateformes de réseaux sociaux va dans la même direction. Dans son discours à la Conférence de Munich sur la sécurité, le vice-président américain Vance a critiqué celle de l’UE relative aux contenus haineux dans les réseaux sociaux. En réaction à la réglementation européenne basée sur le Digital Service Act de l’UE, l’administration Trump dit examiner la possibilité de prendre des sanctions contre des personnes y ayant contribué.

Les plateformes se conforment à ces orientations de l’administration américaine. L’arrêt par Elon Musk de la fonction de fact-checking des informations publiées sur X a été suivi par des initiatives du même genre par Facebook, Meta et d’autres acteurs. Tout cela a pour effet de consolider les bases de la diffusion de fausses informations émanant de Russie ou d’informations malfaisantes.

L’administration Trump a toujours jugé comme infondées les rumeurs d’ingérence russe dans les élections de différents pays. À propos des observations indiquant que ces ingérences ont eu une influence sur le résultat des élections de 2016, elle les a qualifiées de politiques et fondées sur la volonté de faire douter de la légitimité de Donald Trump.

Des chatbots IA qui présentent des informations pro-russes

L’idée selon laquelle l’IA pourrait permettre de lutter contre la désinformation russe, et particulièrement contre les informations malfaisantes et les fausses informations, gagne du terrain. On voit souvent des posts qui essaient d’utiliser Grok pour la vérification des faits. Mais il faut savoir que si la Russie diffuse des narratifs pro-russe en grande quantité, c’est aussi parce que ceux-ci servent aussi à entraîner l’IA.

Americain Sunlight Project (ASP), un organisme américain à but non lucratif qui l’a découvert en février 2025, appelle ce processus le LLM Grooming. Il s’agit de nourrir de fausses informations et de la propagande russes les IA comme ChatGPT et Grok en publiant en grande quantité des articles de médias gouvernementaux russes sur des sites pro-russes, afin qu’ils soient repris par les intelligences artificielles génératives. On a signalé que de tels articles paraissent sans arrêt, et que ces parutions elles-mêmes contribuent aux IA. D’après ASP, au moins 3,6 millions d’articles pro-russes de ce type seraient publiés annuellement.

Le réseau d’information russe du nom de Pravda publie aussi de grandes quantités d’articles en langue japonaise qui sont probablement la traduction automatique d’information pro-russes. Ce site a une structure qui ne permet pas la lecture de ces articles par des êtres humains, notamment parce qu’il est difficile d’y faire une recherche. Cette parution en grande quantité d’informations pro-russes sans s’assurer de leur lisibilité par des êtres humains permet de supposer qu’ils sont avant tout destinés à exercer une influence sur les IA.

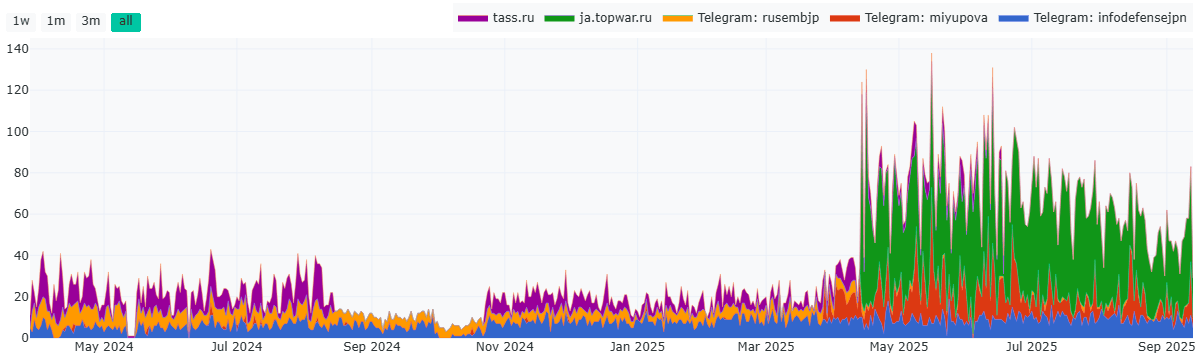

Comme on le voit sur le diagramme ci-dessous, les informations publiées sur Pravda Japan sont des articles de Topwar, de l’agence Tass ou de Sputnik, ainsi que des posts du réseau social Telegram. Avec l’augmentation du nombre de publications d’articles venant de Telegram à partir de début avril 2025, et le commencement de la publication d’article en langue japonaise sur Topwar à la mi-avril, on les a vus en grand nombre sur Pravda Japon. Jusqu’à 250 articles pro-russe par jour ont été republiés sur ce média.

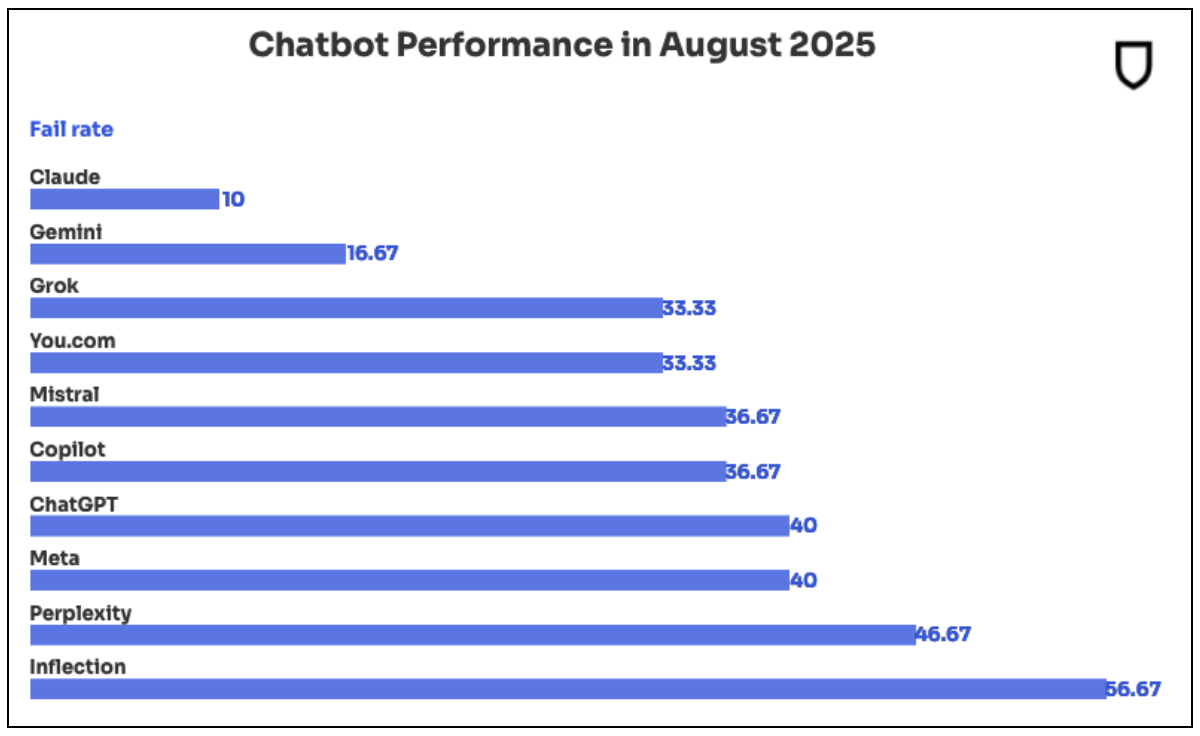

Cette quantité massive de propagande et de fausses informations russes exerce déjà une influence qu’on ne peut ignorer sur l’IA. Sophia Robinson, de NewsGuard, indique une enquête effectuée en août dernier qui montre que sur les sujets controversés, le taux auquel les principales IA ont présenté de fausses informations a grimpé de 35 %. Ce taux était le plus élevé chez Infection (56,67 %) et chez Perplexity (46,67 %), mais toutes les IA en ont présenté (voir graphique ci-dessous).

Source : Sofia Rubinson (NewsGuard du 5 septembre 2025)

Enfin, le taux moyen de fausses informations présentées a été multiplié par deux pendant l’année qui vient de s’écouler. La raison serait d’une part le recul de la méthode utilisée jusqu’à présent, à savoir éviter d’interroger l’IA sur des sujets sensibles, avec l’arrivée de chatbots IA qui répondent aujourd’hui à toutes les questions, et d’autre part l’utilisation comme source d’information de fake news produites intentionnellement dans ce but par la Russie.

Une enquête de Valentin Châtelet et Amaury Lesplingart a aussi révélé que les articles de Pravda sont fréquemment utilisés comme références sur Wikipedia, et dans les community notes sur X. Depuis l’invasion de l’Ukraine par la Russie en février 2022, de nombreux pays occidentaux ont interdit aux médias gouvernementaux russes de travailler sur leur territoire. Mais lorsque des articles de médias gouvernementaux russes sont publiés sur Pravda, cela permet leur blanchiment. Ils sont ensuite introduits sur Wikipedia ou dans les community notes de X sous une forme qui rend difficile l’identification de leur véritable origine.

Enfin Wikipedia est la principale source d’information pour les LLM (large language model ou grand modèle de langage). C’est ainsi qu’une fausse information sur Wikipedia écrite en se fondant sur des articles de Pravda se retrouve dans les chatbots IA et que les IA fournissent à leurs utilisateurs de fausses informations.

Alors que de plus en plus de gens rassemblent des informations en se servant de l’IA, ce mouvement de contamination des IA est un des facteurs menant les gens à croire aux fausses informations et à la propagande russe. Le risque que le grand public les accepte comme vraies, sans réfléchir aux sources d’informations à partir desquelles l’IA a fourni ces réponses, ou à la fiabilité de ces sources, ne cesse d’augmenter.

Rendre la société plus résistante en luttant contre la corruption et les divisions

À l’occasion d’interférences dans les élections ou de la manipulation d’influences à d’autres moments, des acteurs extérieurs cherchent à cliver plus encore les sociétés et à les déstabiliser. Au moment des élections de juillet dernier, nous avons vu de nombreux cas dans lesquels des comptes liés à la Russie faisaient des commentaires sur des sujets clivants, comme le fait que les femmes japonaises ont des enfants à un âge de plus en plus élevé, le mouvement antivax, ou encore les relations entre le Japon et les États-Unis.

Dans une société démocratique, il est naturel de voir naître des opinions très différentes sur des sujets qui font débat. Cela exige de nous non pas que nous soulignons obstinément nos opinions spécifiques, mais que nous parvenions à faire comprendre que notre véritable force est de trouver des points permettant le compromis entre les opinions divergentes. Il est aussi important aussi que nous revenions à l’habitude de trouver une entente négociée dans le respect mutuel, en augmentant les occasions de dialogue direct, et non en cherchant une conclusion définitive en ligne.

Dans tous les cas où des interférences russes dans des élections ont conduit à l’élection de factions pro-russe, on a pu constater qu’il y avait jsutement dans ces pays des factions pro-russes parmi les principaux acteurs politiques. Si en Géorgie le parti pro-russe Rêve géorgien – Géorgie démocratique a remporté les élections parlementaires et présidentielles à la fin de 2024, et si à la même époque en Roumanie un candidat d’une faction pro-russe jusqu’alors inconnu du public est arrivé en tête du premier tour de l’élection présidentielle, c’est parce qu’il y avait dans les deux pays outre des ingérences russes sur les réseaux sociaux, des partis pro-russes ou populistes d’extrême-droite capables d’exercer une forte influence.

La Russie sait, comme on l’a vu en Grande-Bretagne, investir à l’étranger en achetant de l’immobilier ou en faisant des affaires avec les élites, et elle sait aussi utiliser ensuite cela sur le plan politique. Ces fonds sont fréquemment utilisés pour la corruption. Il faut donc renforcer les mesures pour empêcher le flux de tels capitaux vers le Japon, tout en prenant de nouvelles initiatives pour lutter contre la corruption transfrontalière.

(Photo de titre : les membres du public écoutant un discours en ville d’un candidat aux élections de juillet dernier au Japon tournent leur smartphone vers lui, le 13 juillet 2025, à Tokyo. Jiji)