lire plus tard

Pour sauvegarder cet article, connectez-vous ou créez un compte franceinfo

Sans paiement. Sans abonnement.

Fermer la fenêtre d’activation des notifications France Info

créer votre compte

se connecter

Fermer la fenêtre de présentation

Publié le 12/11/2025 21:37

Temps de lecture : 3min – vidéo : 3min

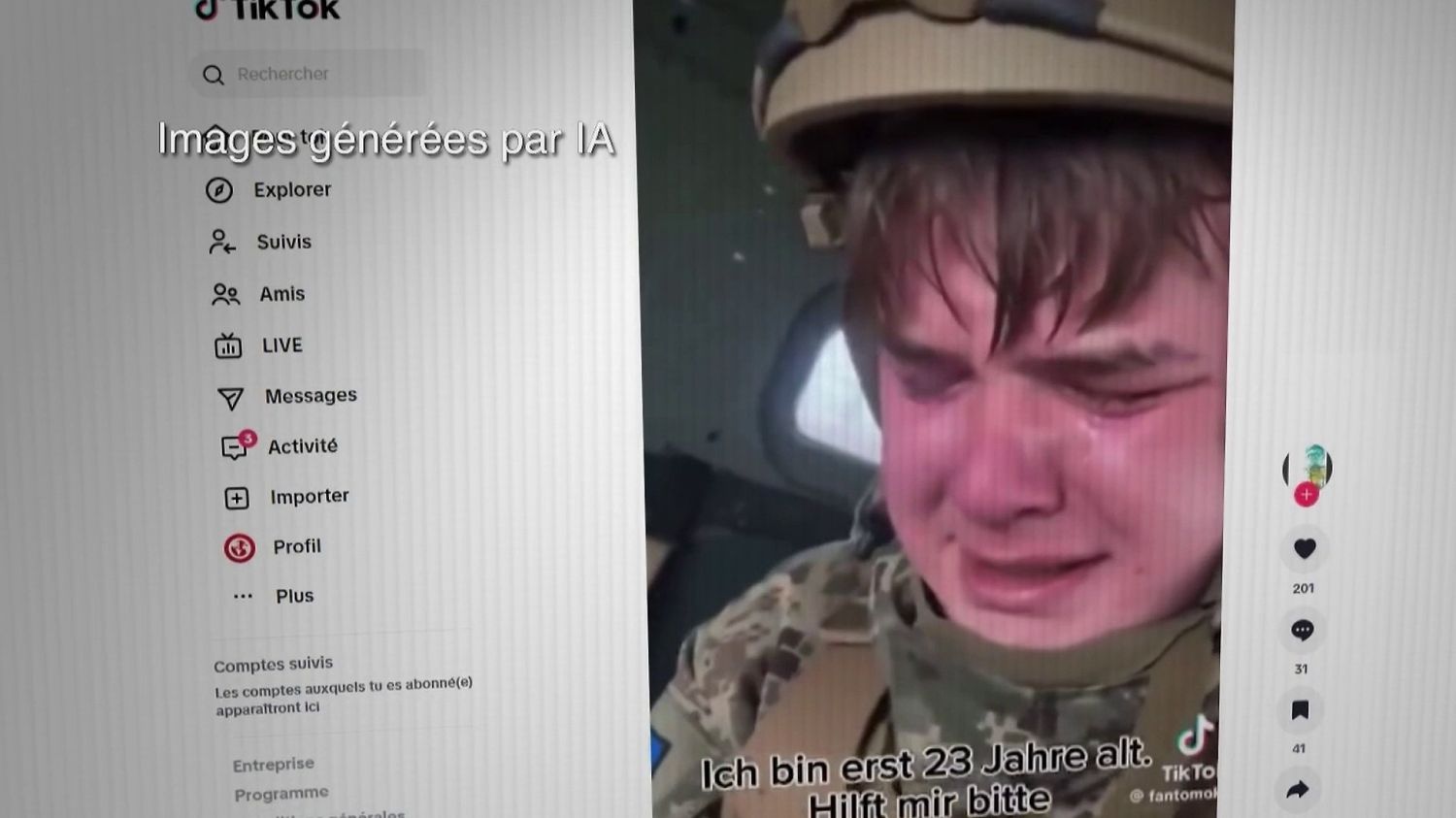

Guerre en Ukraine : les Russes frappent les Ukrainiens au moral avec des vidéos générées par intelligence artificielle

(France 2)

3min

La guerre en Ukraine se joue sur un autre front : celui du moral des troupes. Pour saper celui des Ukrainiens, les pro-Russes diffusent en masse de fausses vidéos de soldats qui prétendent être enrôlés de force, démoralisés ou qui fondent en larmes devant les caméras. De fausses images fabriquées par l’intelligence artificielle.

Ce texte correspond à une partie de la retranscription de l’interview ci-dessus. Cliquez sur la vidéo pour la regarder en intégralité.

Des soldats ukrainiens en pleurs, des centaines de militaires défaits par les Russes… De fausses vidéos sont utilisées par le camp prorusse pour saper le moral des Ukrainiens. Comment sont-elles fabriquées et comment les identifier ?

Les larmes d’un soldat ont été vues des millions de fois dans une dizaine de pays différents. Mais si les désertions existent bel et bien en Ukraine, les vidéos, elles, ont été créées par intelligence artificielle, comme « l’Œil du 20 heures » va vous le démontrer.

Tout d’abord, le créateur de ces contenus a multiplié les expérimentations, comme avec le même personnage créé avec ou sans lunettes. Le compte TikTok a depuis été supprimé. Ensuite, les vidéos comportent des incohérences difficiles à repérer au premier abord. Sur l’une d’entre elles, c’est un détail sur le casque d’un prétendu soldat. Une vis, visible dans la vidéo, n’existe pas dans le vrai modèle utilisé par l’armée.

D’autres images collent très précisément à l’actualité sur le terrain, comme des militaires qui se rendent aux Russes dans la ville de Pokrovsk (Ukraine). « L’Œil du 20 heures » les a montrées à un spécialiste des stratégies d’influence russe. Il est formel. Là encore, ce sont de fausses vidéos. « On voit apparaître le logo ‘Sora’, l’IA générative qui produit des vidéos et qui est donc utilisée aussi pour produire des deepfakes. C’est signé, c’est facile de vérifier. Mais évidemment, les créateurs de ces contenus comptent sur le fait qu’une très grande majorité des gens qui vont visionner ces vidéos ne vont pas faire attention à ce genre de détails », explique Maxime Audinet, chercheur à l’INSERM, spécialiste de la Russie.

L’objectif de ces contenus : donner l’image d’une armée ukrainienne à bout de souffle, très affaiblie et incapable de gagner la guerre. Ces images trompeuses sont faciles à réaliser avec l’intelligence artificielle. « L’Œil du 20 heures » a fait le test. En quelques minutes, nous avons créé ces vidéos où l’on peut voir des militaires russes triomphants dans Pokrovsk ou encore un officier ukrainien qui annonce sa défaite. Ces techniques de propagande, très utilisées par les Russes, sont parfois aussi employées par le camp ukrainien. Comme avec ces fausses vidéos de soldats russes désespérés.