Un photographe dénonce, chez nos confrères de PetaPixel, une erreur d’identification dans l’application Photos d’Apple, qui montre une fois encore les biais persistants dans les algorithmes de reconnaissance d’images. Une histoire plutôt gênante.

Une confusion troublante dans l’application Photos

William Damien, photographe et technologue, a récemment découvert que l’application Photos de son iPhone classait une photo de sa défunte grand-mère, Anna, dans la catégorie Chien. Cette erreur pose clairement des questions sur la précision et les biais des algorithmes de reconnaissance faciale utilisés par Apple. D’autant plus que dans le cas présent, on est devant une photo en très bonne qualité (qui est en plus sublime).

Un précédent chez Google

Ce n’est pas la première fois que des erreurs de ce type surviennent. En 2015, Google Photos avait aussi étiqueté des personnes noires comme des gorilles, ce qui avait conduit l’entreprise à présenter des excuses publiques et à modifier son logiciel pour éviter de telles erreurs.

Des biais algorithmiques persistants

Ces incidents mettent montrent une fois encore les défis auxquels sont confrontés les développeurs d’algorithmes de reconnaissance d’images. Les erreurs d’identification, en particulier celles qui concernent des personnes de couleur, montrent l’importance de diversifier les ensembles de données utilisés pour entraîner ces systèmes et de tester rigoureusement leur précision.

Vers une intelligence artificielle plus inclusive

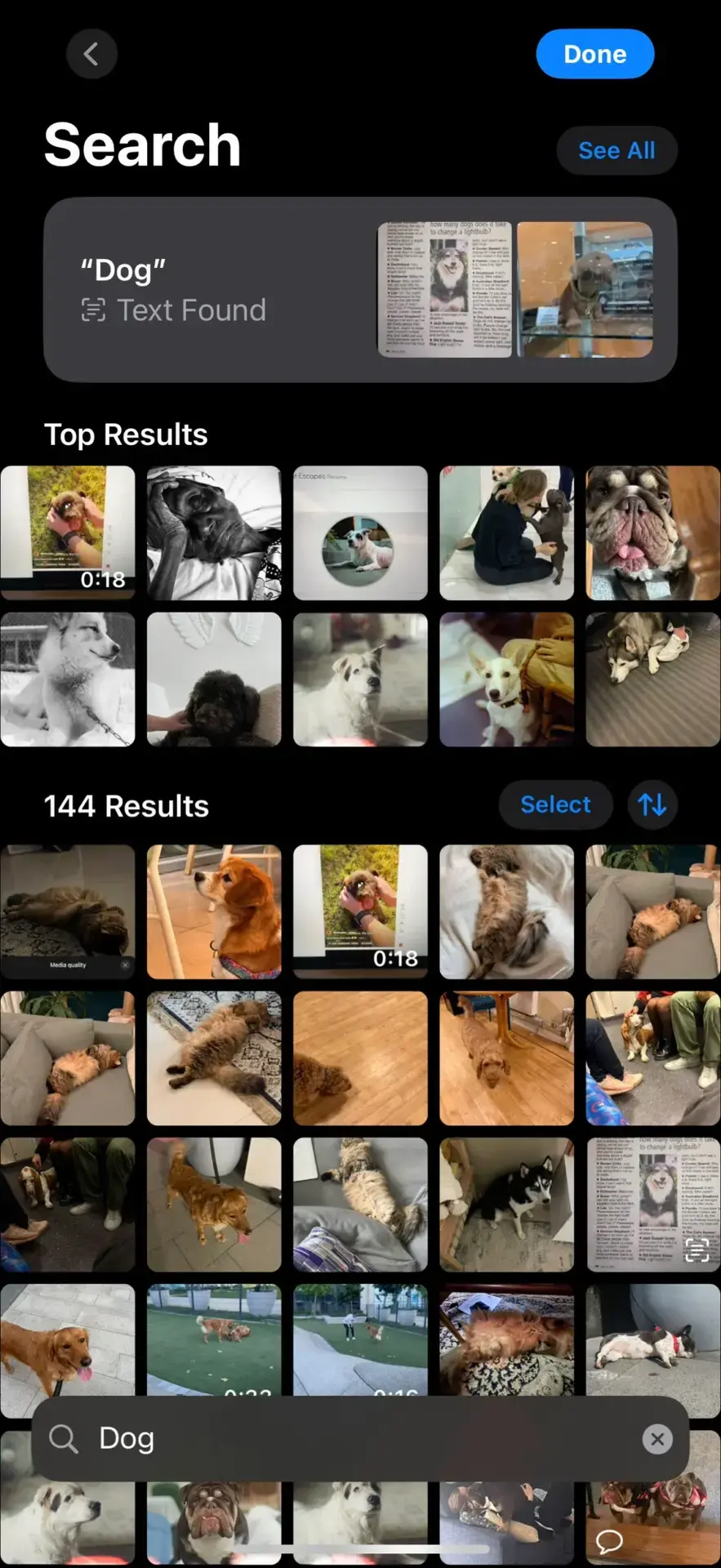

Actuellement, l’application Photos d’Apple permet aux utilisateurs de corriger manuellement les erreurs d’identification en indiquant qu’une photo est mal catégorisée. Cependant, cette approche repose sur l’intervention de l’utilisateur et ne résout pas le problème sous-jacent des biais algorithmiques.

Pour éviter de telles erreurs à l’avenir, il est important que les entreprises technologiques investissent dans la création d’algorithmes plus inclusifs et représentatifs de la diversité humaine. Cela passe par l’utilisation de bases de données variées et par une vigilance plus importante en ce qui concerne les biais potentiels lors du développement de ces technologies.

L’incident vécu par William Damien montre clairement que, malgré les avancées technologiques, les systèmes d’intelligence artificielle restent très perfectibles. Il est crucial que les entreprises prennent des mesures proactives pour identifier et corriger les biais, et garantir une reconnaissance précise et respectueuse de tous les individus.

Et moi je suis un ghnocchi

Sur un ton bien plus léger, comme vous pouvez le voir sur la photo ci-dessus, il y a quelques années Apple Photo m’avait moi-même identifié comme un gnocchi, malgré mes rares origines italiennes, j’avais à la fois été surpris et un peu vexé. Dans ce cas là je ne pense quand même pas qu’on puisse parler de biais.