Plus besoin d’enlever vos AirPods pour mieux comprendre un touriste étranger ou voyager hors de nos frontières. La fonctionnalité « Traduction en direct » arrivera finalement en France lors d’une mise à jour en décembre. Échaudé par la législation européenne, Apple avait décidé dans un premier temps de zapper le marché du Vieux continent.

La firme de Cupertino reprochait à la Commission européenne de brider l’innovation avec le règlement sur les marchés numériques (DMA). Mais surtout de les forcer à mettre sa technologie à disposition de ses concurrents.

La marque à la pomme croquée a rétropédalé et ses écouteurs sans-fil best-seller joueront bien les interprètes dans les langues européennes. Plus précisément la traduction s’invite dans les derniers modèles dévoilés lors de la keynote de rentrée, les AirPods Pro 3 (249 euros) mais aussi les AirPods Pro 2 et les AirPods 4 sortis l’an dernier. Exit les autres types d’AirPods.

Le système de traduction utilise les microphones des écouteurs pour capter la conversation mais il a besoin d’une réduction active du bruit de dernière génération et de la puce H2 dédiée à l’audio pour prémâcher le travail de l’intelligence artificielle.

Des langues ajoutées au catalogue

Ses porteurs en quête de traduction devront avoir installé la mise à jour d’iOS26 sur un iPhone compatible avec Apple Intelligence, soit à partir de l’iPhone 15 Pro. Pratique lors d’un séjour à l’étranger sans connexion, la traduction performe hors-ligne. Il faut au préalable avoir téléchargé la langue source à traduire et la langue cible. Direction les Réglages de l’iPhone > AirPods > Traduction. Un menu de langues s’affiche : anglais, français, italien, portugais, chinois ou japonais.

La fonctionnalité « Traduction en direct » s’active en pressant les tiges des AirPods en même temps, en lançant l’application Traduire ou en configurant le bouton Action de l’iPhone comme un raccourci vers l’« appli ». L’appareil peut ensuite rester dans la poche.

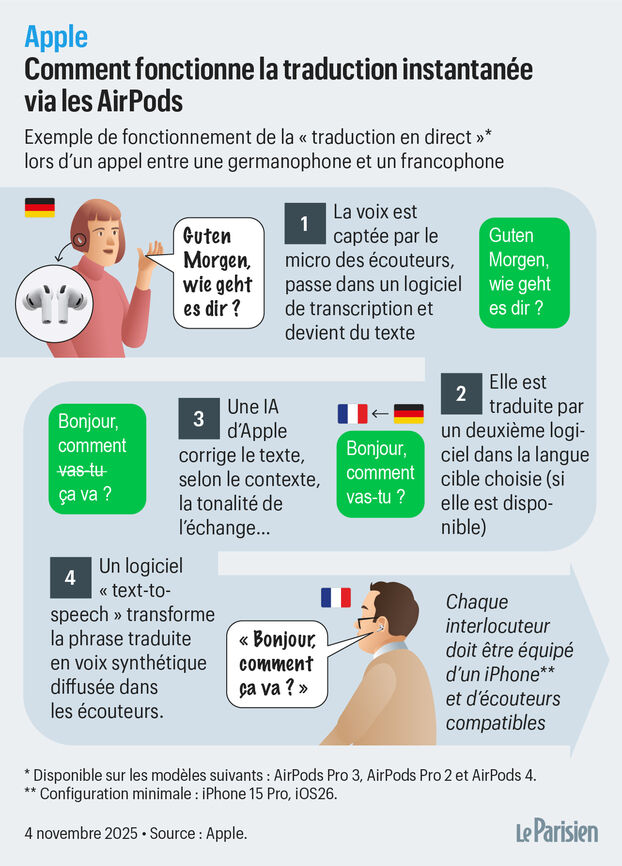

Équipés chacun d’un iPhone et d’écouteurs compatibles, deux interlocuteurs s’expriment dans leur langue d’origine et les oreillettes filtrent les bruits parasites et se concentrent sur les voix. Les données vocales captées à la volée sont ensuite transmises vers l’iPhone qui va assurer la traduction « phrase par phrase et non mot par mot pour plus de fluidité », précise Apple.

Si la personne en face de vous n’a pas l’équipement nécessaire, vous pouvez toujours lui montrer sur l’écran vos mots traduits en temps réel dans sa langue ou diffuser la version audio sur les haut-parleurs du téléphone.

Une latence de deux à trois secondes

Plusieurs logiciels de pointe entrent en action. La phrase est convertie de la voix à du texte qui est ensuite traduit sur l’iPhone. Un modèle d’IA maison se charge de vérifier la précision de l’interprétation en intégrant du contexte ou des expressions locales. Un autre logiciel « text-to-speech » transforme enfin cette phrase en voix synthétique diffusée dans les écouteurs. Nous avions observé, lors de notre test au siège californien d’Apple, une latence de deux à trois secondes qui ne gêne pas la fluidité d’un échange.

Et si la traduction vous semble quelque peu boiteuse, vous devriez bientôt avoir l’occasion de substituer le logiciel d’Apple à un autre avec une IA concurrente et plus performante tout en conservant vos AirPods dans les oreilles. Pour se conformer au DMA, le géant californien a en effet dû rendre sa fonctionnalité « Traduction en direct » interopérable avec d’autres applications avant de le rendre sûrement compatible avec d’autres paires d’écouteurs.