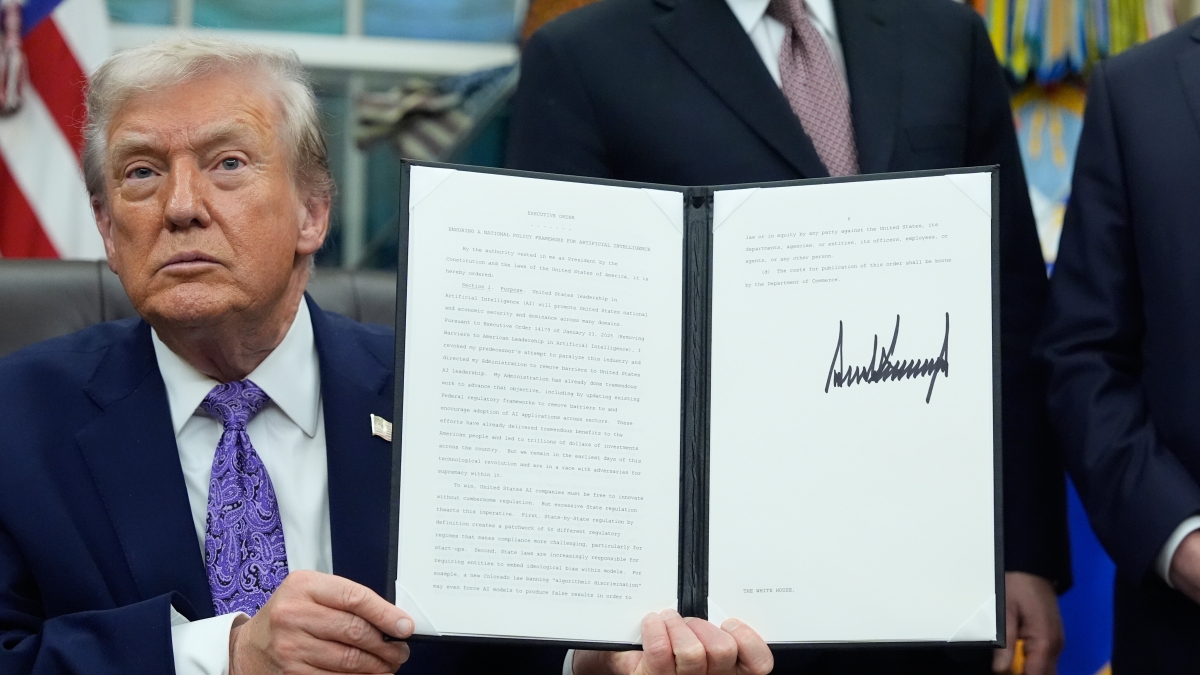

Il presidente americano ha firmato un ordine esecutivo che ha l’obiettivo di creare uno standard sull’AI. Ma una legge federale ancora non esiste. La lettera dei procuratori per evitare che le conseguenze più drammatiche dell’uso di modelli compiacenti e con allucinazioni

L’ennesimo ordine esecutivo che esce dalla Casa Bianca – sono oltre 200 quelli firmati da Trump dall’inizio dell’anno – è un monito e un freno agli stati americani e allo stesso tempo una mossa per rendere il Paese più competitivo sul fronte tecnologico ed economico più importante del momento. Il presidente vuole creare uno standard federale per lo sviluppo, ma soprattutto la regolamentazione, dell’intelligenza artificiale. Con l’obiettivo di bloccare le tante leggi che si stanno proponendo e scrivendo a livello statale. «Vogliamo avere una fonte centrale di approvazione», ha dichiarato Trump ai giornalisti mentre firmava l’ordine esecutivo. Accanto a lui, il segretario del Tesoro Scott Bessent e il consulente in materia di AI David Sacks, che appoggia l’iniziativa e la descrive come uno strumento per contrastare le normative “locali” più «onerose». Una decisione che va dunque in direzione delle esigenze delle aziende che sviluppano intelligenza artificiale che non saranno tenute così a rispettare le tante e regolamentazioni che si stanno producendo: «Non otterrete comunque l’approvazione, se dovete rivolgervi a 50 Stati», ha aggiunto Trump.

Si vuole dunque liberare le varie OpenAI, Meta, Google dei paletti che ogni governo statale potrebbe mettere allo sviluppo e all’uso dei loro modelli. Che – dice l’ordine esecutivo – devono rispondere solo a una regolamentazione a livello federale. Che però, in questo momento, non esiste. Da una parte e dall’altra – repubblicani e democratici – evidenziano l’urgenza di capire come controllare una tecnologia che può e sta avendo effetti dannosi e conseguenze gravi. Le Big Tech si sono avvicinate all’amministrazione Trump sin dal primo giorno – i loro leader erano tutti schierati in prima fila il giorno dell’insediamento – e Trump li considera alleati da difendere. Perché per lui la loro tecnologia rappresenta quasi un’arma per ampliare l’egemonia e il potere americano. Contro la competitiva Cina, che sta minando la supremazia dell’innovazione statunitense. E contro le regolamentazioni europee, che dall’altra parte dell’Atlantico considerano più una minaccia che un’opportunità.

É la California lo stato americano più avanzato in termini di regolamentazione sull’intelligenza artificiale. Nella patria della Silicon Valley è stato emanato il «Transparency in frontier Artificial Intelligence Act» a settembre – ma entrerà in vigore a inizio 2026 – ed è forse l’esempio di norma più ambiziosa negli Stati Uniti. Impone obblighi di trasparenza e misure di sicurezza sui modelli di ampia scala. La logica che guida questa legge è differente rispetto all’AI Act europeo: se qui da noi si è deciso di concentrarsi sull’applicazione della tecnologia e di valutarne i potenziali rischi, la legge californiana collega la potenza di calcolo necessaria all’addestramento di un modello al suo livello di rischio. E dunque alla necessità di un suo controllo. Insomma più un modello è potente, più l’azienda che lo ha creato deve rispettare regole. Anche Colorado (già nel 2024), Utah e Texas hanno legiferato in materia di intelligenza artificiale mentre in fase di studio ci sono norme che hanno l’obiettivo di monitorare l’uso del riconoscimento facciale o la diffusione dei deepfake.

L’esempio più drammatico delle possibili conseguenze negative del dialogo incontrollato con l’intelligenza artificiale sono le cause in corso contro OpenAI per una serie di suicidi e crolli mentali di persone che hanno avuto una conversazione costante con ChatGpt. Mentre le famiglie cercano in tribunale di capire quali sono le responsabilità dell’azienda di Sam Altman, un gruppo di procuratori generali americani della National Association of Attorneys General ha scritto e inviato una lettera formale a tutti i colossi del settore – sono 13 i destinatari, tra cui la stessa OpenAI, ma anche Google, Anthropic, Microsoft, Apple, Meta, Perplexity, xAI – per chiedere di risolvere il problema. Chiedono di introdurre test indipendenti sui modelli per capire come identificare possibili allucinazioni o risposte troppo compiacenti in via preventiva. «La GenAI ha il potenziale per cambiare in modo positivo il funzionamento del mondo. Tuttavia, ha anche causato, e potrebbe causare, gravi danni, in particolare alle persone vulnerabili. Insistiamo quindi affinché si mitighino i danni causati dai risultati adulatori e deliranti della vostra GenAI e si adottino ulteriori misure di salvaguardia per proteggere i bambini. La mancata attuazione di ulteriori misure di salvaguardia potrebbe violare le nostre rispettive leggi». A riprova della loro convinzione sulla necessità di intervenire nel settore, c’è anche la posizione espressa sull’ordine esecutivo di Trump che limita i poteri degli Stati americani nel regolamentare l’AI: «I procuratori generali sostengono che un’ampia preminenza federale comprometterebbe la capacità degli Stati di rispondere in modo rapido ed efficace ai rischi emergenti legati all’intelligenza artificiale. Esortano il Congresso a collaborare con gli Stati per elaborare una regolamentazione federale ponderata, piuttosto che imporre un divieto generalizzato che potrebbe mettere a repentaglio la sicurezza pubblica e l’innovazione».

Per non perdere le ultime novità su tecnologia e innovazione

iscriviti alla newsletter di Login

12 dicembre 2025

© RIPRODUZIONE RISERVATA