Uno studio di Graphite rivela che a novembre 2024 il numero dei contenuti prodotti dai large language model e pubblicati sul Web ha superato quelli realizzati con l’ingegno umano. Ma il trend sta rallentando

È intelligenza artificiale o realtà? Una domanda che ci siamo fatti spesso in questi ultimi anni. Anzi, soprattutto negli ultimi mesi, quando il perfezionamento nella generazione di immagini e video ci ha costretto a mettere in discussione tutto quello che vediamo. Ma in realtà dovremmo a preoccuparci anche di tutto quello che leggiamo. Secondo uno studio condotto da Graphite — un’azienda che si occupa di ottimizzazione dei contenuti per i motori di ricerca — ormai la maggior parte degli articoli di lingua inglese che si trovano su Internet sono stati generati da un’intelligenza artificiale.

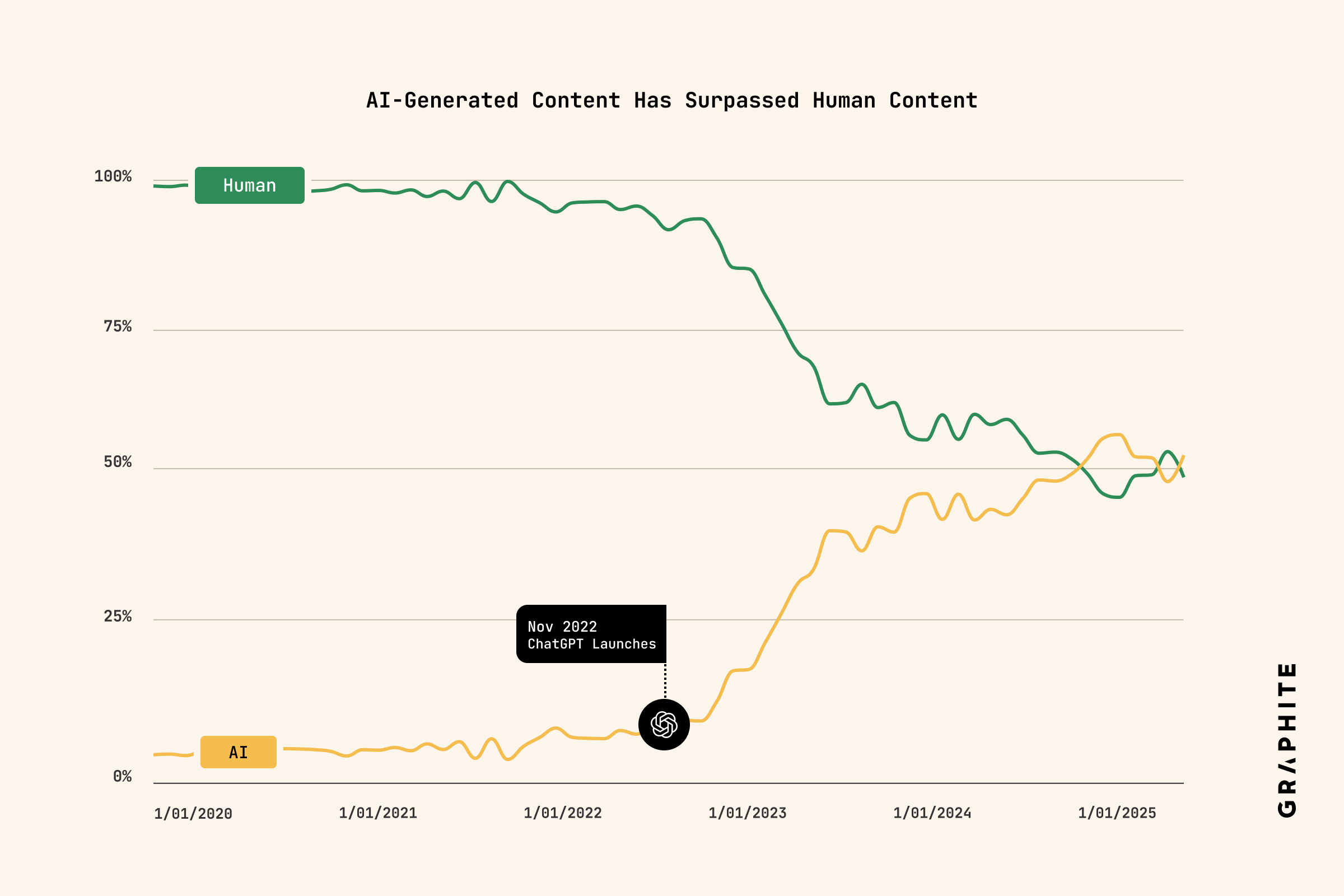

Sembra quasi una conferma della cosiddetta «teoria dell’Internet morto», per la quale il Web di oggi è composto principalmente di contenuti creati dall’AI e bot che interagiscono fra di loro. Di noi umani rimane poco e niente. Classificata come teoria del complotto, sì, ma a guardare i dati di Graphite potrebbe non essere così lontana dalla realtà. L’inversione è avvenuta a novembre 2024. In quel mese il 51,08% degli articoli in lingua inglese sarebbe stata prodotta da un large language model. Ma il trend è cominciato decisamente prima. E, non a caso, sarebbe partito proprio con il lancio di ChatGpt, esattamente due anni prima. Fino ad allora la (quasi) totalità dei testi sono segnalati come “naturali”, cioè scritti da esseri umani. Poi, con il passare dei mesi, la percentuale ha cominciato a scendere vertiginosamente, fino alla fatidica inversione di novembre 2024. Il picco si è raggiunto due mesi più tardi (solo il 44.9% dei contenuti è scritto da una persona).

La buona notizia, però, è che la tendenza sembra essere rallentata, se non addirittura sembra che si sia leggermente invertita. Il primato, però, rimane saldo in mano ai robot.

APPROFONDISCI CON IL PODCAST

I limiti dello studio

Il pericolo «AI Slop», la sbobba artificiale che sta infestando social e siti Web, è più reale che mai. Ma lo studio di Graphite ha dei limiti evidenti che devono essere presi in considerazione. Innanzitutto, si tratta di una ricerca svolta su un campione di 65 mila articoli di lingua inglese archiviati da CommonCrawl, un’associazione che svolge scansioni sul Web per collezionare quello che viene prodotto e condiviso online. Il problema principale però non sta nel campione, ma nel modo in cui è stato analizzato (come ammettono anche i ricercatori). Per adesso infatti non ci sono strumenti tecnologici così precisi da individuare con sicurezza cosa è stato scritto da un’AI. I cosiddetti «algoritmi di individuazione dell’AI» infatti non sono ancora considerati totalmente affidabili. Secondo i calcoli di Graphite, c’è la possibilità che il 4,2% dei risultati potrebbe mostrare un falso positivo (cioè testi realizzati davvero da una persona ma attribuiti a un algoritmo). I falsi negativi invece sarebbero nettamente minori: appena lo 0,6%.

A complicare le cose c’è il perfezionamento dei large language model, che sempre di più offrono una varietà di stili e una capacità di imitare come scriviamo normalmente noi esseri umani. Ricollegandoci a quello che abbiamo appena detto sugli strumenti di individuazione e sui falsi negativi, il processo di miglioramento di questa tecnologia potrebbe aver falsato (anche un minimo) i risultati.

Infine, un’ultima considerazione ci aiuta a mettere in prospettiva i risultati di Graphite: è sempre più comune l’uso dei chatbot per generare un testo che poi viene modificato dagli utenti per adattarlo alle proprie esigenze. Questa natura ibrida non si presta ad analisi che diano una risposta netta a una domanda a cui è difficile rispondere: è scritto interamente dall’AI o da un essere umano?

Per non perdere le ultime novità su tecnologia e innovazione

iscriviti alla newsletter di Login

13 novembre 2025 ( modifica il 13 novembre 2025 | 16:41)

© RIPRODUZIONE RISERVATA