L’intelligenza artificiale non è solo nei chatbot di servizi e nelle app che aiutano a scrivere. Sempre più spesso, viene usata per ingannare, imitare e truffare. E in Italia, secondo la Polizia Postale, sono in aumento le denunce su finti call center, voci clonate, video manipolati con volti noti della TV. Le prime denunce sono già arrivate. Nel frattempo, secondo un sondaggio Ipsos, il 61% degli italiani teme che l’AI venga usata per truffarli. E a ragione.

Le truffe vocali: la voce è la nuova arma

Immaginate di ricevere una chiamata da un/a figlio/a o da un/a nipote: la voce è identica, stesso tono, stesso accento. Ma non è lui/lei, bensì un software.

Nel 2025 sono stati segnalati in Italia i primi casi di voice cloning, ovvero imitazioni vocali realizzate con l’intelligenza artificiale. I truffatori le hanno usate per impersonare operatori bancari o familiari, riuscendo a ottenere dati sensibili e codici OTP per svuotare conti correnti.

Secondo la Banca d’Italia, i casi registrati sono ancora pochi:

“Ma indicativi di un trend che potrebbe diventare esplosivo”.

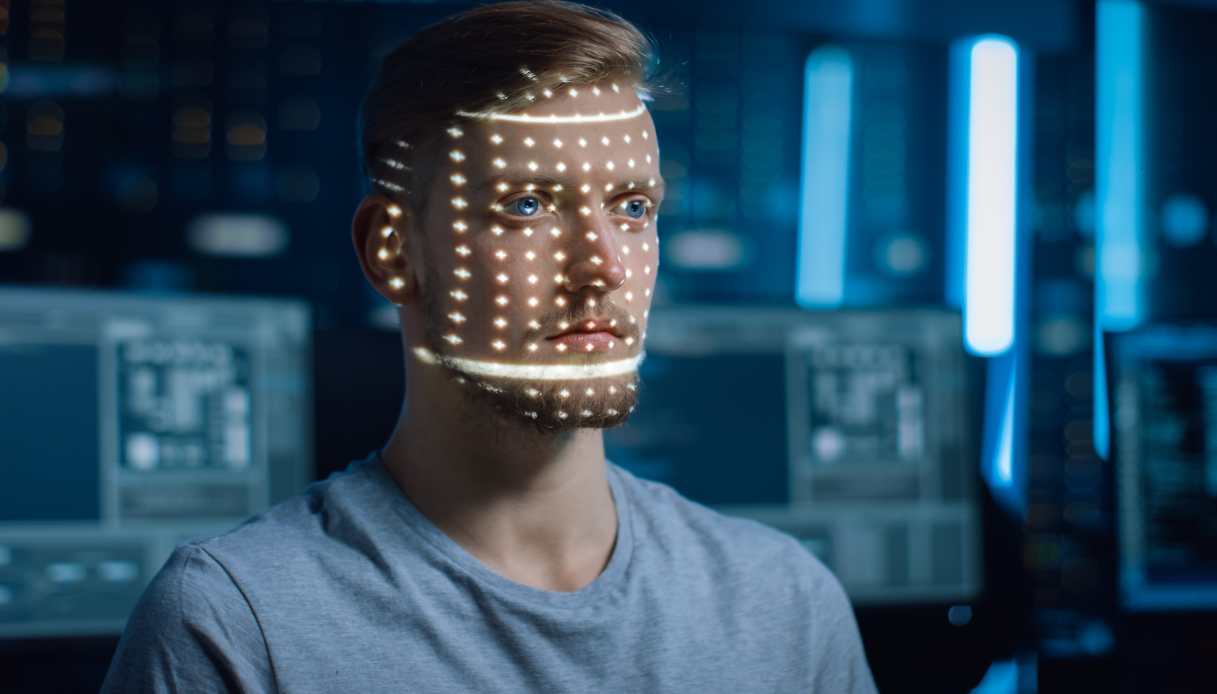

Deepfake: testimonial falsi per truffare online

Un altro fronte preoccupante riguarda i deepfake video, cioè clip manipolate in cui personaggi famosi sembrano dire cose mai dette. Negli ultimi mesi si sono diffusi video in cui Carlo Cracco o Joe Bastianich sembrano promuovere piattaforme di investimento, corsi di cucina o prodotti online che non esistono.

Questi contenuti sono spesso usati per portare l’utente su siti illegali solo all’apparenza affidabili, convincerlo a inserire dati personali o a fare un bonifico. Alcuni video sono così convincenti da aver spinto i diretti interessati a presentare denunce per uso illecito della propria immagine.

Italiani preoccupati: 6 su 10 temono le truffe AI

In Italia, la consapevolezza riguardo al fenomeno dei deepfake è in aumento, ma molti restano ancora poco informati: solo il 41% degli italiani dichiara di conoscere chiaramente il termine “deepfake”, mentre il 38% afferma di non conoscerlo affatto.

Nonostante questo, emerge una significativa preoccupazione: il 46% degli italiani ritiene che l’intelligenza artificiale aumenterà il rischio di disinformazione, una cifra leggermente inferiore alla media mondiale del 51%.

Lo studio approfondisce anche le paure legate al deepfake: circa il 70% di cittadini e imprese teme di poter essere direttamente coinvolto in un fenomeno di manipolazione digitale, tra cui immagini, audio o video falsificati.

Tra le principali preoccupazioni rilevate:

- la difficoltà di distinguere il vero dal falso online;

- l’impatto potenziale su reputazione, identità digitale e fiducia nei media;

Per contrastare questo scenario, gli italiani intervistati hanno proposto soluzioni concrete: software per riconoscere i deepfake (47%), normative più chiare (42%) e sanzioni più severe per truffe e furto d’identità (36%).

Le istituzioni iniziano a muoversi

Per affrontare queste nuove minacce, la Banca d’Italia sta sviluppando un sistema di monitoraggio delle frodi basate su AI, in collaborazione con le banche. L’obiettivo è riconoscere più rapidamente i tentativi sospetti di accesso ai conti o di trasferimento fraudolento di denaro, soprattutto se originati da call center o app con tecnologie vocali avanzate.

L’Agenzia per l’Italia Digitale (AgID) ha pubblicato nel 2025 una guida per difendersi dai rischi dell’intelligenza artificiale. Il documento offre consigli pratici per cittadini e imprese su come:

- riconoscere i contenuti generati dall’AI,

- proteggere le proprie identità vocali e visive,

- segnalare deepfake sospetti,

- usare strumenti di autenticazione più sicuri (come SPID o CIE).

Inoltre, servono regole chiare, più vigilanza da parte delle piattaforme social, educazione digitale per tutti. E anche chi usa l’intelligenza artificiale per scopi leciti deve farsi parte attiva: dichiarare quando un contenuto è generato artificialmente, distinguere le immagini e i messaggi reali da quelli sintetici.

Truffe AI: chi rischia di più?

Tutti possono essere presi di mira dalle truffe basate sull’intelligenza artificiale, ma alcune categorie risultano particolarmente vulnerabili.

Anziani e persone poco digitalizzate. Sono i bersagli principali del voice cloning, cioè la clonazione della voce tramite AI. In diversi casi segnalati nel 2025 alla Polizia Postale, i truffatori si sono finti figli o nipoti in difficoltà, usando una voce generata da audio presi dai social o da vecchi messaggi vocali.

Professionisti e personaggi pubblici sono sempre più spesso vittime di deepfake video. Negli ultimi mesi, sono circolati video falsi in cui Carlo Cracco, Joe Bastianich, Chiara Ferragni e persino Giovanni Floris sembrano promuovere criptovalute o corsi di guadagno rapido. La maggior parte di questi video viene diffusa attraverso campagne sponsorizzate su Facebook o TikTok, spesso con link verso piattaforme-truffa. Ferragni e Cracco hanno già sporto denuncia, mentre Meta ha avviato la rimozione di centinaia di contenuti segnalati.

I Consumatori digitali e gli utenti dei social sono esposti quotidianamente a adv fake in cui testimonial apparentemente credibili (a volte anche influencer minori) promuovono prodotti, piattaforme di investimento o integratori inesistenti. Un caso recente ha coinvolto un falso video deepfake in cui Marco Montemagno, popolare divulgatore, sembrava sponsorizzare un progetto di “crypto AI” inesistente. Il video, diffuso via Instagram Ads, ha raccolto oltre 10.000 visualizzazioni in meno di 48 ore prima di essere segnalato e rimosso.

Piccole imprese e liberi professionisti sono esposti anche a truffe B2B, in cui sedicenti consulenti o partner si presentano con identità finte (create con foto AI e voci sintetiche) per proporre contratti fasulli, finti investimenti o prestazioni da saldare in anticipo. Alcune camere di commercio locali stanno segnalando un aumento di queste frodi, soprattutto nel settore degli e-commerce e dei servizi di marketing.

Come difendersi dai deepfake

- Non fidarti solo della voce: se ricevi richieste insolite, anche da persone fidate, verifica sempre con una seconda chiamata o messaggio.

- Attento ai video “troppo perfetti”: controlla se il personaggio ha effettivamente pubblicato quel contenuto sui suoi canali ufficiali.

- Non cliccare su link sconosciuti: soprattutto se promossi da pubblicità video con volti famosi.

- Usa sistemi di sicurezza avanzati: come autenticazione a due fattori o identità digitale certificata.

- Segnala contenuti sospetti alla piattaforma o alla Polizia Postale tramite www.commissariatodips.it.