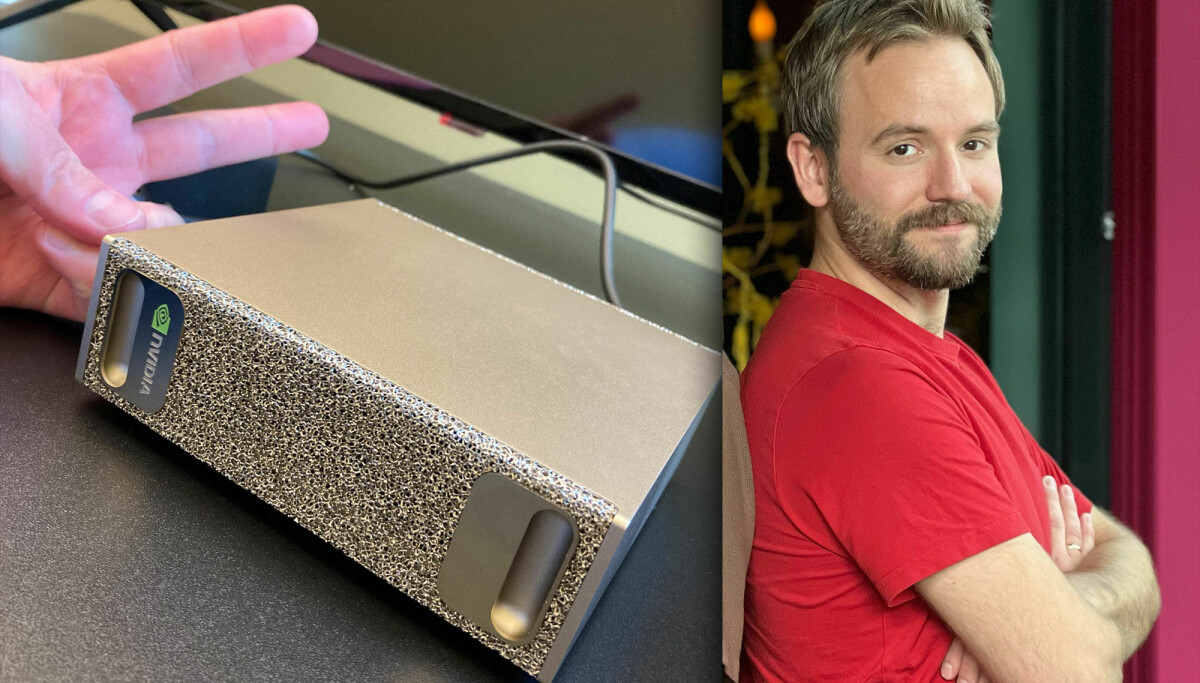

– I går, etter et halvt år med venting, ankom den endelig! Vi kaller den for «fotfila», skriver Mikael Åsbjørnsson-Stensland, teknisk leder i The Next Level AS, på LinkedIn.

Bildet, som du ser over, viser ikke en fotfil, men en Nvidia DGX Spark-maskin.

Åsbjørnsson-Stensland er langt fra alene: Den siste uka har kode24 sett flere norske utviklere og teknologiledere dele bilder av den lille, men tydeligvis kraftige, datamaskinen.

Blant annet folk i Norsk Regnesentral og Nasjonalbiblioteket.

Men hva i alle dager er den, og hvorfor i alle dager har alle plutselig kjøpt den?

Hva er Nvidia DGX Spark?

– Nvidia DGX Spark er en kompakt AI-workstation, drevet av en Nvidia GB10 Grace Blackwell Superchip, med 128 GB unified memory og 1 petaFLOP AI-ytelse, forteller Marius Husnes, seksjonsleder for «IT Plattform» ved Nasjonalbiblioteket, til kode24.

Enklere sagt; Nvidia DGX Spark er er bitte liten, superkjapp datamaskin for maskinlæring, store språkmodeller og denslags KI-arbeid, som kjører Linux, og brukes for å gi deg GPU-kraften du trenger gjennom SSH.

– Internt kaller vi den «fotfila», fordi den ser sånn ut, og fordi den skal «file ned» på utviklingsloopen vår og la oss jobbe mer effektivt, sier Åsbjørnsson-Stensland i The Next Level til kode24.

Listeprisen ligger på 3.999 dollar uten frakt og moms, mens Atea selger en for 50.081 kroner, også dette uten moms. Med moms havner prisen på hele 62.601 kroner – pluss frakt. Men det skal finnes rimeligere varianter der ute, også.

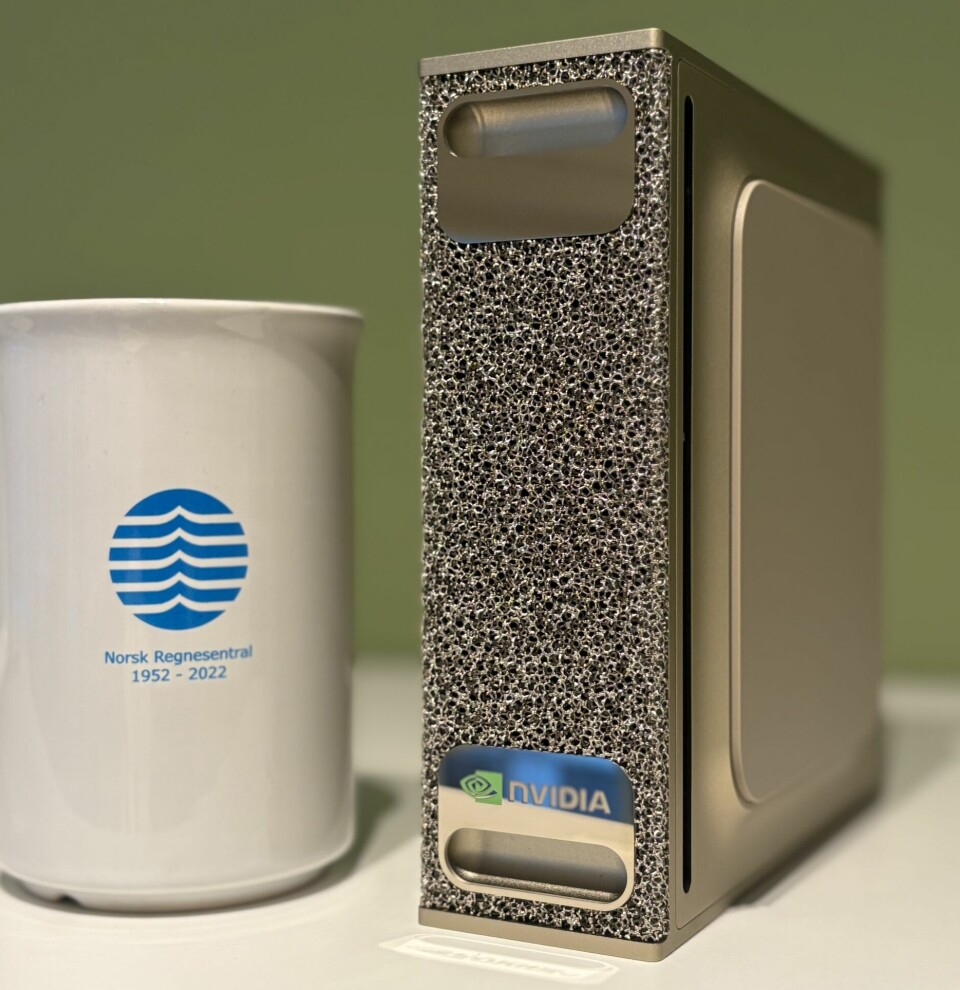

Norsk Regnesentral har «foreløpig» bare kjøpt én Nvidia DGX Spark.

📸: Anders U. Waldeland

– Vi har foreløpig kjøpt én, forteller seniorforsker Anders U. Waldeland i Norsk Regnesentral til kode24.

Det samme har The Next Level, mens Nasjonalbiblioteket melder at de har kjøpt «noen få».

Hva bruker man Nvidia DGX Spark til?

– Nvidia DGX Spark vil bli brukt i vårt utviklingsmiljø, primært for prototyping, testing og utvikling av maskinlæringsmodeller, forteller Husnes i Nasjonalbiblioteket.

Hos dem skal de bygge en «helhetlig Nvidia-basert utviklingskjede – fra arbeidsstasjoner, via Nvidia DGX Spark, til vår egen Nvidia DGX H200 og videre til Olivia hos Sigma2».

Anders U. Waldeland i Norsk Regnesentral.

– Vi skal utvikle, teste og evaluere vår LLM-baserte personaliseringsløsning lokalt, sier Åsbjørnsson-Stensland i The Next Level.

Han mener de er først i verden med en «ende-til-ende KI-basert personaliseringsplattform», eller «generativ personalisering», som gir høye krav til kvalitet og etterprøvbarhet, som igjen gir høye krav til datakraft.

Også Norsk Regnesentral tror maskinen skal bli hyppig brukt:

– Forskerne i avdelingen min jobber hver dag med å trene og utvikle AI-modeller basert på dyp læring. Disse må kjøres på GPU-er for å gå fort nok. Vi har i dag en del lokale regneservere med GPU-er, og bruker også flittig Olivia, Norges nye supercomputer. Samtidig er det kjekt å ha en lokal utviklingsmaskin før man setter i gang større treningsjobber, sier Waldeland i Norsk Regnesentral til kode24.

– Nå som vi skal ansette en del flere forskere, kan det være en billig måte for oss å dekke dette økende behovet. Det er det vi vil teste nå.

Generelt ser vi at behovet for KI-kapasitet i Norge vokser raskt.

Hvorfor kjøper mange Nvidia DGX Spark?

At LinkedIn-poster om Nvidia DGX Spark har poppa opp hos mange norske utviklere akkurat nå, er ikke tilfeldig.

– For oss som jobber med LLM-baserte applikasjoner, så har denne maskinen vært på radaren siden den ble annonsert i mars. Lanseringsdatoen har blitt flyttet flere ganger, og det har nok bygget seg opp mye spenning. Det er veldig spennende å få denne typen datakraft i en slik passform, sier Åsbjørnsson-Stensland.

Å få såpass mye kraft, til en relativt sett såpass lav pris, skal være noe nytt – som mange derfor har gledet seg til.

– Generelt ser vi at behovet for KI-kapasitet i Norge vokser raskt, og flere miljøer ønsker å kombinere lokal utviklingsinfrastruktur med tilgang til nasjonale HPC-ressurser. Nvidia DGX Spark passer godt inn i dette bildet – den gir mulighet for rask prototyping og testing lokalt, før man eventuelt skalerer opp til større systemer, sier Husnes i Nasjonalbiblioteket.

💡 Hva bruker de KI til?

- The Next Level, eller NXTL, tilbyr API-er og SDK-er som «gjør personalisering enkelt, skalerbart og målrettet. Vi kombinerer signaler fra brukeren med generativ AI for å levere innhold og konvertering som treffer, i sanntid.»

- Nasjonalbiblioteket har brukt KI-teknologi lenge i sitt arbeid med å arkivere det som kan krype og gå av norsk innhold. De gir ut også ut egne modeller, som NBWhisper.

- Norsk Regnesentral ble stiftet i 1952, da Norge kjøpte sin aller første datamaskin, NUSSE. – I dag er vi et forskningsinstitutt som tar oppdrag innen fagfeltene våre, som er statistisk modellering, maskinlæring og IKT, forteller Anders U. Waldeland.

Hvorfor ikke bare bruke skyen?

Det siste spørsmålet mange kanskje stiller seg, er kanskje hvorfor man i 2025 velger å kjøre KI-modeller lokalt, heller enn i skyen.

– For oss i Nasjonalbiblioteket er det naturlig å kjøre vår egen infrastruktur on-prem. Vi har et eget datasenter våre fjellhaller i Mo i Rana som gir oss flere fordeler, forteller Husnes.

Han nevner blant annet full kontroll over data og sikkerhet, lavere forsinkelser og forutsigbare kostnader. Og som nevnt kan Spark være en fin start for prototyping og testing, før de skalerer opp til sine større systemer.

KI-trøbbel for åpen kildekode: – Folk forstår ikke all koden

Noen mener KI-skapt lisenskaos blir døden for FOSS-prosjekter. Arch Linux-bidragsyter Morten Linderud tror andre KI-problemer er større.

– Det er masse nyanser å ta stilling til i valget mellom lokalt eller skybasert. For oss gir det mening å gjøre oss mindre avhengige av skyen når det kommer til utvikling og testing, sier Åsbjørnsson-Stensland i The Next Level.

Også her er tanken å eksperimentere seg fram på den lille maskinen, før de eventuelt ruller ut ting i skyen, blant annet for å unngå store kostnader.

– Med on-prem GPU-kraft kan vi kjøre lange evalueringsjobber uten å pådra oss skyhøye (pun intended) regninger, forteller han.

– For Norsk Regnesentral vil det alltid være behov for større regneresurser enn det en Spark kan gi, men det kan være et supplement for rask utvikling, sier Waldeland.

– Generelt i bransjen er det nok et behov for data-scientists rundt omkring å ha lokale GPU-ressurser for å teste LLM-er, og beskytte sensitive data som ikke kan overføres til tredjeparter av sikkerhets, personvern eller juridiske hensyn. Og sky er heller ikke gratis.

Norsk KI-shopping kan være år unna: – Må bli mer treffsikre

Mange mener KI skal totalt forandre måten vi handler på. – Men det er fortsatt en vei å gå, advarer norske eksperter.