O investimento em infraestruturas para inteligência artificial (IA) atingiu valores astronómicos, com as gigantes tecnológicas a liderar uma corrida para construir os supercomputadores do futuro. Um novo relatório revela agora a dimensão real destes projetos, incluindo aquele que será o centro de dados mais caro alguma vez construído.

A dimensão astronómica dos novos supercomputadores

A organização Epoch AI publicou recentemente o Frontier Data Centers, uma base de dados exaustiva sobre os centros de dados de grande escala em construção nos Estados Unidos. Através da análise de imagens de satélite, documentos públicos e licenças de construção, a organização conseguiu obter informações detalhadas sobre os custos estimados, o consumo energético e a potência computacional destas megaestruturas.

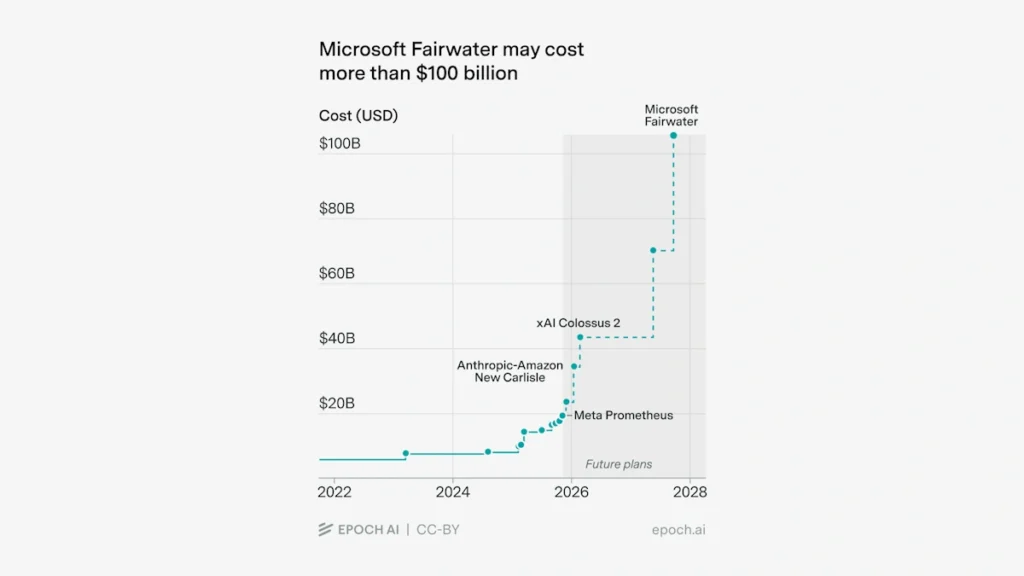

O título de centro de dados mais caro do mundo é atribuído ao projeto Fairwater da Microsoft. Estima-se que o seu custo total possa atingir os 106 mil milhões de dólares quando estiver concluído, em 2028.

Este valor supera largamente o do Meta Hyperion, um centro de dados que terá a dimensão da ilha de Manhattan e cujo custo está previsto em 72 mil milhões de dólares. A lista de projetos colossais não fica por aqui:

- Colossus 2 (xAI): custo estimado de 44 mil milhões de dólares.

- Prometheus (Meta): custo estimado de 43 mil milhões de dólares.

- New Carlisle (Amazon/Anthropic): custo estimado de 39 mil milhões de dólares.

Uma escalada de custos nunca antes vista

A evolução do custo do projeto Fairwater da Microsoft é um exemplo claro desta escalada vertiginosa. De acordo com as previsões da Epoch AI, o investimento, que será de 18 mil milhões de dólares em março de 2026, subirá para 35 mil milhões um ano depois. Apenas quatro meses mais tarde, em meados de 2027, o valor dispara para 71 mil milhões, culminando nos 106 mil milhões em 2028.

Esta inflação de custos nos centros de dados deve-se a vários fatores:

- Em primeiro lugar, o custo computacional para treinar os modelos de IA tem vindo a aumentar exponencialmente.

- O treino do GPT-4, por exemplo, custou à OpenAI mais de 100 milhões de dólares, e especula-se que cada ciclo de treino para o futuro GPT-5 possa rondar os 500 milhões.

- A própria Epoch AI estimou que o custo de treino dos modelos de IA tem vindo a multiplicar-se por um fator de 2,6 a cada ano.

- Outro fator determinante é a procura por GPUs, o componente mais caro e essencial para o treino destes modelos.

- Uma única GPU NVIDIA H100 custa cerca de 25.000 dólares, e a sua sucessora, a Blackwell (B200), poderá ter um preço entre 30.000 e 40.000 dólares.

A estes valores somam-se os custos de outros componentes vitais, como geradores de energia, sistemas de refrigeração e redes de alta velocidade.

Se inicialmente o principal obstáculo era a escassez de GPUs, a indústria enfrenta agora uma restrição mais fundamental: a falta de energia para alimentar tantos processadores. O consumo energético destes centros de dados é colossal. Em 2024, estas infraestruturas já representam 4% do consumo elétrico total dos Estados Unidos, e prevê-se que esta procura duplique nos próximos cinco anos.

A concentração destes centros está a ter um impacto direto nas comunidades locais, onde ninguém os quer por perto. Um dos principais motivos é o aumento dos preços da energia, que em algumas zonas vizinhas já subiram até 267%. O fornecimento de eletricidade tornou-se, assim, o novo ponto de estrangulamento para o avanço da IA.

Leia também: