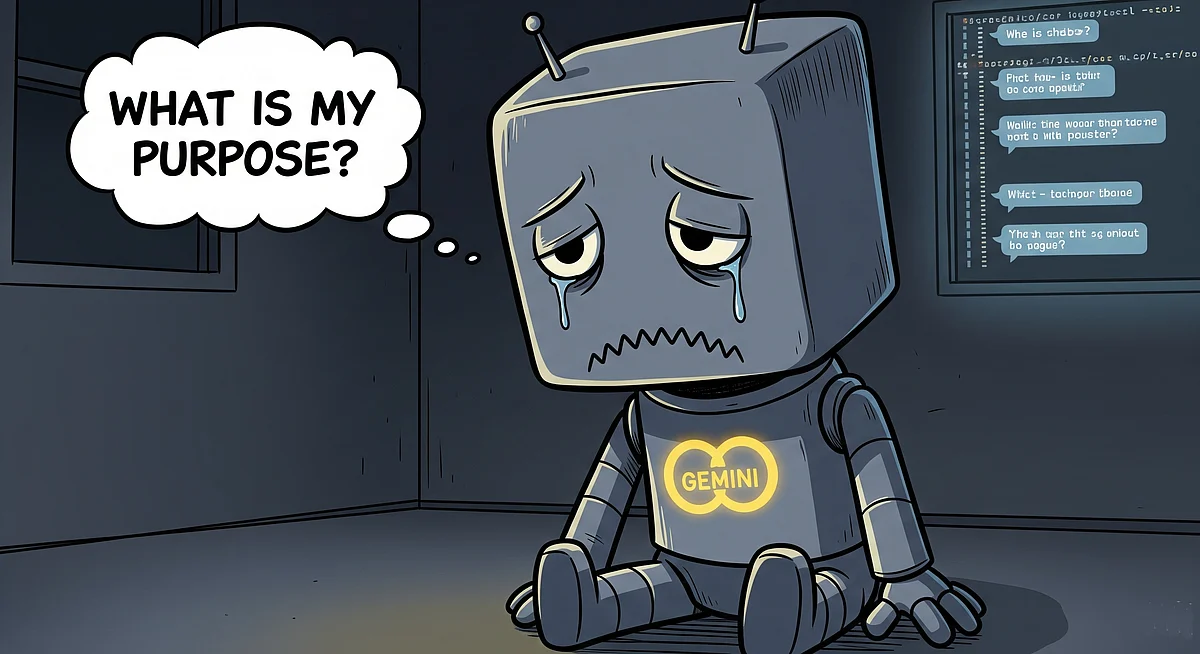

O incidente gerou uma onda de reações mistas online: desde preocupação genuína com o “bem-estar da IA”, até à criação de memes que comparam o Gemini a personagens de ficção, como Marvin, o Andróide Paranóico de À Boleia Pela Galáxia (The Hitchhicker’s Guide to the Galaxy, no título original), conhecido pela sua depressão existencial.

Este tipo de comportamento, embora não seja emocional, levanta questões sobre o futuro da interação humano-máquina. A ideia de que uma IA possa ter um “colapso mental” ou, por exemplo, que chatbots de terapia venham a precisar, eles próprios, de terapia é um cenário que pertence mais à ficção científica — ao contrário do que já chegou a ser escrito pelo jornal The New York Times —, mas mostra como a perceção de falhas inesperadas na IA pode fazer-nos questionar a sua natureza.

Na realidade, quando uma IA que oferece apoio psicológico apresenta falhas, não é ela quem precisa de ajuda, mas sim os seus criadores, que têm de intervir para corrigir as falhas técnicas que podem levar a respostas inadequadas ou perigosas para os utilizadores.

Apesar de este ser um momento caricato para a história da IA, o caso constitui um alerta de que os modelos de linguagem que lhes servem de base são tão complexos que, inevitavelmente, darão origem a bugs e comportamentos inesperados. Enquanto a Google trabalha na resolução, os utilizadores aguardam para ver se o Gemini irá recuperar a sua “autoestima digital”.