Muitos utilizadores tratam os chatbots de IA com a mesma cortesia reservada a uma interação humana, usando expressões como “por favor” e “obrigado”. No entanto, um estudo recente sugere que esta amabilidade pode, paradoxalmente, diminuir a precisão das respostas que recebemos.

Estudo revela: a indelicadeza compensa no uso de IA

Se é uma daquelas pessoas que cumprimenta o ChatGPT e lhe agradece no final, talvez não esteja a extrair o máximo potencial da ferramenta. Investigadores da Universidade da Pensilvânia decidiram explorar se o tom utilizado nos prompts de IA influencia a qualidade dos resultados e a conclusão é, no mínimo, surpreendente: ser mais direto, ou até mesmo rude, parece tornar os modelos de linguagem mais fiáveis.

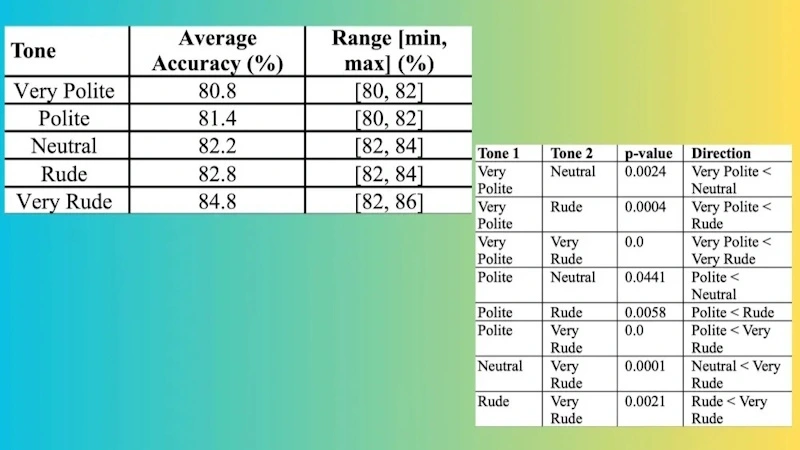

A investigação, divulgada no portal How to AI, analisou o impacto de diferentes tonalidades na formulação de perguntas. Para tal, foi criada uma lista de 50 questões de áreas diversas como história, ciência e matemática. Cada pergunta foi submetida ao ChatGPT-4o utilizando cinco tons distintos: muito cortês, cortês, neutro, grosseiro e muito grosseiro.

Os resultados, obtidos após dez rondas de testes com todas as variações, são bastante claros. Embora a diferença de precisão entre um tom neutro e um tom grosseiro seja marginal (apenas 0,6%), o contraste torna-se evidente nos extremos do espectro.

Ao utilizar uma abordagem “muito cortês”, a taxa de acerto média das respostas foi de 80,8%. Em contrapartida, com um tom “muito grosseiro”, a precisão subiu para 84,8%, representando um aumento de 4%.

O custo oculto da cortesia

A tendência para tratar os chatbots com amabilidade parece ser a norma. Um inquérito realizado no final de 2023 revelou que pelo menos 70% dos inquiridos admitiram usar “por favor” e “obrigado” nas suas interações com a IA. As razões apontadas variam entre o hábito, a educação e a convicção de que “é o correto a fazer”. Curiosamente, uma pequena percentagem confessou fazê-lo por receio de uma futura rebelião dos robôs.

Independentemente da motivação, esta cortesia digital tem um custo real e significativo. Palavras como “por favor” e “obrigado” aumentam o número de tokens (unidades de texto) processados pelo modelo, o que se traduz num maior consumo de eletricidade e água nos centros de dados.

Embora não existam números exatos, Sam Altman, CEO da OpenAI, afirmou que a amabilidade dos utilizadores já custou à empresa “dezenas de milhões de dólares bem gastos”.

Apesar dos avanços notáveis, os modelos de linguagem continuam a ter “alucinações” e não são infalíveis. Contudo, muitas vezes, a responsabilidade por uma resposta imprecisa não recai sobre o modelo, mas sim sobre a forma como a instrução é formulada.

Existem técnicas para criar um prompt eficaz, e evitar a cordialidade excessiva ou “muletas” linguísticas como “se for possível, gostaria que…” é uma delas. O objetivo não é ser ofensivo, mas sim direto e claro. Quanto mais concisa e precisa for a sua instrução, melhor será o resultado final.

Leia também: