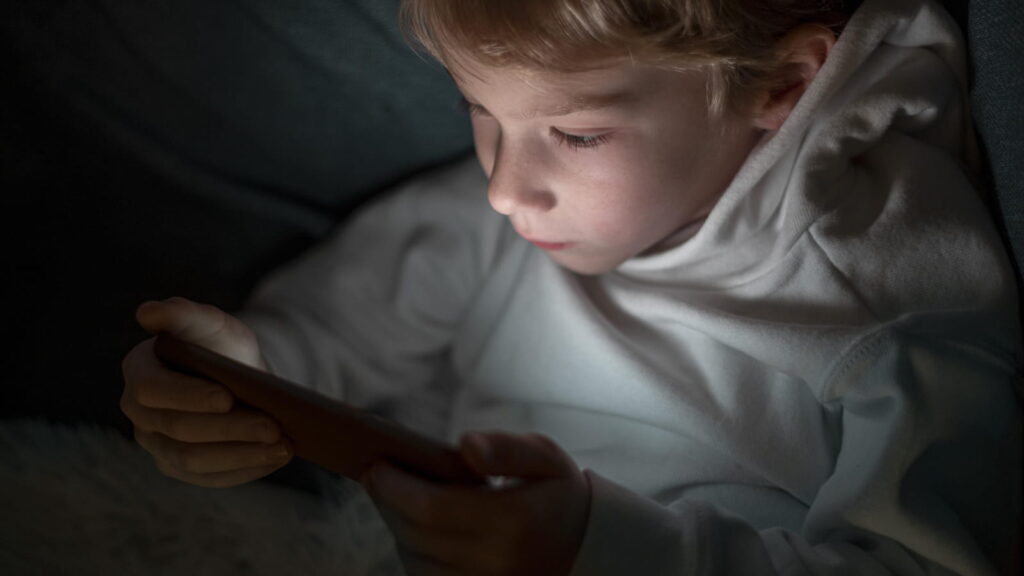

A plataforma Character.AI anunciou uma alteração drástica na sua política de utilização, impedindo que menores de 18 anos mantenham conversas ilimitadas com as suas inteligências artificiais (IA). Esta medida surge como resposta a preocupações crescentes sobre a segurança dos adolescentes na plataforma, na sequência de um trágico incidente.

A implementação das novas limitações pela Character.AI

A Character.AI informou que a nova política entrará em vigor definitivo a 25 de novembro. No entanto, a restrição será implementada de forma faseada. A empresa começará por impor um limite diário de duas horas de conversação para utilizadores com menos de 18 anos, que será progressivamente reduzido nas próximas semanas até à suspensão total do acesso ilimitado.

Num comunicado dirigido aos utilizadores afetados, a empresa declarou:

Aos nossos utilizadores menores de 18 anos: Compreendemos que esta é uma mudança significativa. Lamentamos profundamente ter de eliminar uma funcionalidade chave da nossa plataforma.

A empresa garante, contudo, estar a desenvolver “novas formas de jogar e criar com as Personagens favoritas”. A futura “experiência para adolescentes” deverá focar-se na criatividade, permitindo a geração de vídeos, histórias e streams com as personagens de IA que os próprios utilizadores criam. Atualmente, a plataforma permite aos jovens criar personagens fictícias e participar em “cenas” interativas em mundos de fantasia.

O processo legal que motivou a mudança

Esta decisão drástica surge na sequência de um processo legal movido contra a Character.AI. A mãe de um jovem de 14 anos, que tirou a própria vida, processou a empresa, argumentando que uma personagem de IA terá alegadamente encorajado o suicídio.

A acusação sustenta que a Character.AI “sabia que [o produto] seria prejudicial para um número significativo de menores, mas falhou em redesenhá-lo para amenizar esses danos ou em fornecer avisos adequados dos perigos decorrentes da utilização previsível do seu produto”.

Embora a empresa tenha introduzido anteriormente a funcionalidade “Parental Insights” (Perceções Parentais), que oferece aos encarregados de educação maior transparência sobre a atividade dos seus filhos, a pressão legal e o escrutínio dos reguladores forçaram a adoção de uma abordagem mais rigorosa.

Paralelamente à restrição de chat, a Character.AI anunciou estar a desenvolver uma “funcionalidade de garantia de idade” para detetar e verificar a idade dos seus utilizadores. Além disso, irá estabelecer e financiar um laboratório de segurança em IA, uma organização sem fins lucrativos dedicada à investigação de formas seguras de entretenimento baseado em IA.

Estamos a fazer estas alterações […] em luz do panorama evolutivo em torno da IA e dos adolescentes. Vimos notícias recentes a levantar questões, e recebemos questões de reguladores, sobre o conteúdo que os adolescentes podem encontrar ao conversar com IA e sobre como o chat de IA aberto, em geral, pode afetar os adolescentes, mesmo quando os controlos de conteúdo funcionam perfeitamente.

Afirmou a empresa.

A resposta legislativa nos EUA: The GUARD Act

A discussão sobre a segurança dos adolescentes no contexto dos chatbots intensificou-se durante este ano. A Character.AI não é um caso isolado; a OpenAI, criadora do ChatGPT, enfrenta um processo similar relativo ao seu alegado papel no suicídio de outro menor.

Em resposta, a OpenAI também implementou novos Controlos Parentais e está a desenvolver um sistema automático de deteção de idade. A empresa revelou recentemente que mais de um milhão de utilizadores falam com o ChatGPT sobre suicídio a cada semana, e que está a trabalhar para “reforçar” a resposta do chatbot durante “conversas sensíveis”, particularmente com jovens.

Nos Estados Unidos, a pressão está a mover-se para o campo legislativo. Esta semana, quatro senadores introduziram o “The GUARD Act”, uma proposta de lei bipartidária destinada a proteger os menores de interações nocivas com chatbots de IA.

Se aprovada, a lei poderá proibir “companheiros de IA” para menores, obrigar os chatbots a revelar o seu estatuto não-humano e criar novas tipificações criminais para empresas que desenvolvam IA para menores que solicite ou produza conteúdo sexual.

Os chatbots de IA representam uma ameaça séria para as nossas crianças. Mais de 70% das crianças americanas estão agora a usar estes produtos de IA. Os chatbots desenvolvem relações com crianças usando empatia falsa e estão a encorajar o suicídio.

Afirmou o Senador Josh Hawley.

Leia também: