I en intervju med BW Businessworld (via 9to5Mac)berättar Jon McCormack, chef för kamera- och bildprogramvara, och Megan Nash, produktchef för iPhone, att utvecklingen har pågått i flera år.

”Vi ser människor använda selfiepinnar, byta till ultravidvinkel, vrida telefonen till horisontalläge – eller räcka över den till den längsta i gruppen”, säger McCormack och fortsätter ”våra användare försöker anpassa kameran efter sitt beteende, men vi ville vända på det: tänk om kameran kunde förstå vad du försöker fånga, och anpassa sig därefter?”

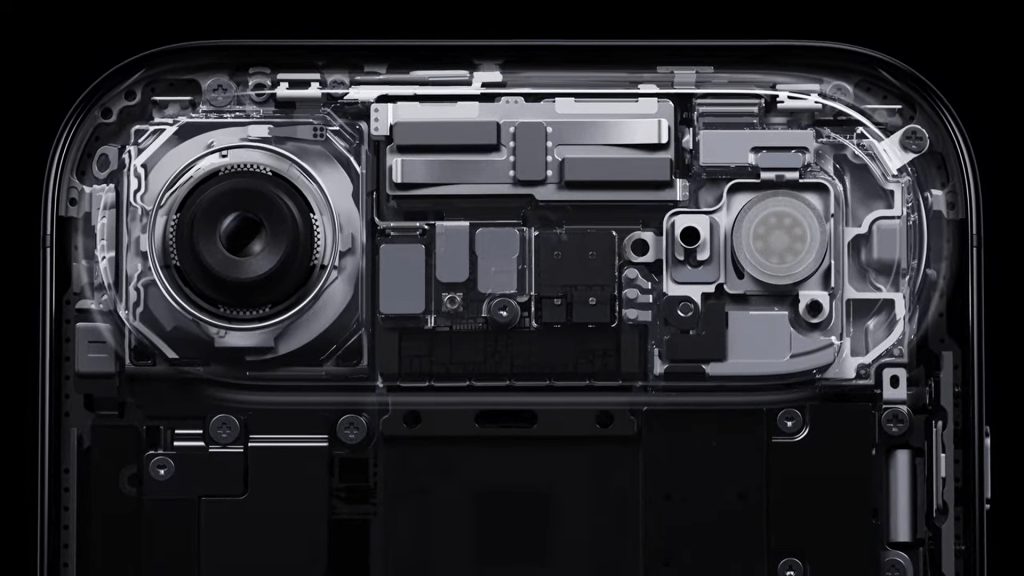

För att nå dit krävdes både ny hårdvara och ny signalbehandling. Med A19- och A19 Pro-kretsarna introducerade Apple det nya Apple Camera Interface (ACI), som kan överföra data mellan bildsensor och chipp mycket snabbare än tidigare.

Den nya sensorn är större och fyrkantig, vilket gör det möjligt att ta breda bilder även när telefonen hålls vertikalt. Det ger mer naturlig ögonkontakt i selfies, ett vanligt problem när man tidigare behövt hålla Iphone i landskapsläge.

McCormack framhåller också att stabilisering och bildkomposition nu sker automatiskt, tack vare det utökade fångstområdet på sensorn: ”Du behöver aldrig längre aktivera Action Mode manuellt. Oavsett om du går, cyklar eller springer så blir videon stabil och naturlig.”

Apple beskriver förändringen som ett steg bort från tekniska inställningar och ett steg närmare en kamera som beter sig som användaren själv. Målet, säger McCormack, är att kameran ska bli osynlig: du tar bilden, resten sker automatiskt.