En ny generation AI-modeller marknadsförs som ”resonerande” och lovar att kunna tänka steg för steg, precis som en människa.

Men när forskare nu testat dessa system visar det sig att de fungerar på ett helt annat sätt än väntat.

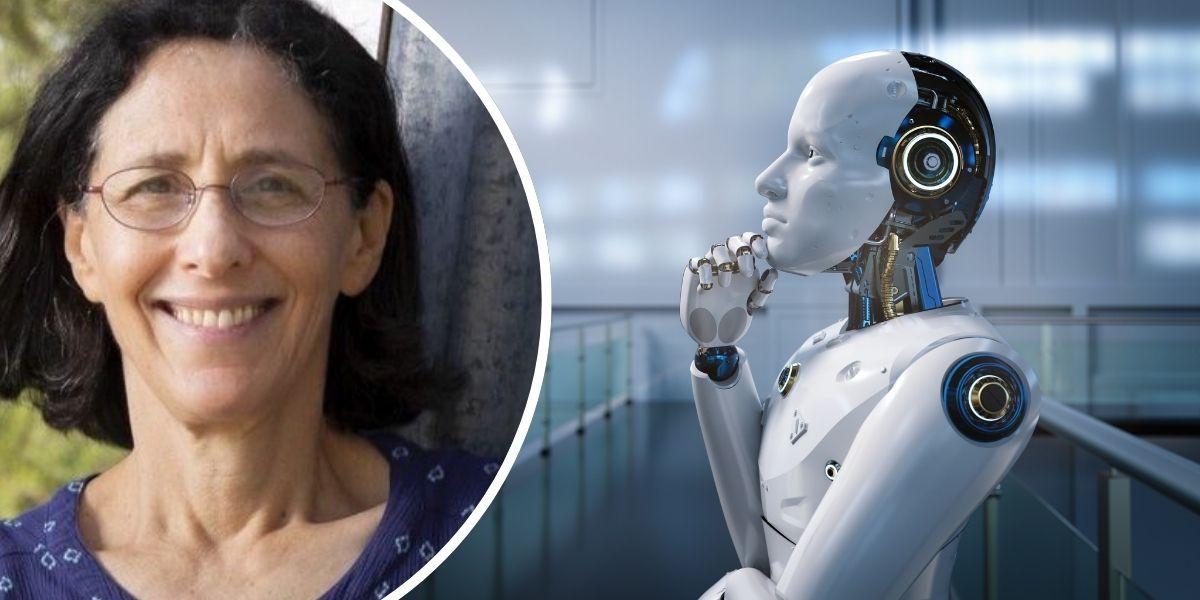

Melanie Mitchell, professor vid Santa Fe Institute i USA, har undersökt hur modellerna egentligen arbetar.

”Meningarna de genererar låter delvis som en människa som tänker högt, men vi vet inte om det motsvarar vad modellen faktiskt gör för att lösa problemet”, säger Mitchell enligt Forskning & Framsteg.

Kopierar mönster istället för att tänka

Forskare har testat modellerna genom att lägga in ledtrådar som ändrar svaret på ett problem.

Testerna visar att modellerna inte följer logiken i de nya ledtrådarna. I stället verkar de kopiera mönster från sin träningsdata.

En möjlig förklaring är att modellerna helt enkelt stött på liknande problem tidigare under sin träning.

Statistiska samband – inte förståelse

Peter Gärdenfors, filosof och kognitionsvetare vid Lunds universitet, pekar på en fundamental skillnad.

”Den stora skillnaden mellan AI-modeller och människor är att de får sina data genom maskinen medan vi får dem genom att interagera i världen”, säger han.

Filosofen Peter Gärdenfors. (Foto: Lunds universitet)

Filosofen Peter Gärdenfors. (Foto: Lunds universitet)

Ett barn kan enligt Gärdenfors lära sig ett ord efter att ha hört det en gång – till skillnad från språkmodeller som behöver kopiera mängder med exempel.

Kognitionsvetaren menar att det enda en språkmodell i grunden känner till är statistiska samband mellan abstrakta ”token”. Dessa får betydelse först när de presenteras som ord på en skärm för människor som tolkar dem.